第一时间捕获有价值的信号

原本计划写一篇《ChatGPT 发布两周年记》的文章,以呼应去年的总结性文章 ChatGPT 发布一周年记,但最近太太忙了,现在都快 1 月中旬了,这个题目已经不太严谨了:),决定换个题目,从开发者角度聊聊过去一年从基础模型到开发者工具生态的个人观察,文章会分为三部分:

基础模型:总结一年来基础模型层面的发展,这个是基本。

开发者工具生态:聊聊大模型开发者工具生态系统的发展,涵盖基础模型服务商、中间层产品以及标志性开源项目。

2025 年关注方向:最后延伸浅谈一下 2025 年个人重点关注的 AI 发展方向。

基础模型

多模态模型

春节期间,Sora 的发布拉开了 2024 年大模型竞争的序幕,这一年多模态模型迅速发展并爆发。不过在开始之前,有必要明确此处所指的多模态模型的含义,当前的多模态模型主要分为两类:一类是专用多模态模型,如文生图模型和文生视频模型,我喜欢将其称为 AIGC 模型;另一类是通用多模态大语言模型,这类模型具备自然语言理解和生成、图像识别以及语音和视频交互的能力,不过随着多模态模型应用逐渐进入到普通用户的生活,一些厂商欺负普通用户没有相关背景,都声称自己支持多模态,所以多模态模型应用在实现上又分为三种(定义来自微软亚洲研究院的《跨越模态边界,探索原生多模态大语言模型》):

- 多模态接口:在系统层开发统一的用户界面,具备多种模态数据输入和多种模态输出的能力,但是实现上则可以通过调用不同模态的模型甚至是 API,在终端实现多模态能力。

- 多模态对齐与融合:在技术框架层将语言模型、视觉模型、声音模型等进行连接,这些模型相互独立学习,使用不同模态的数据进行训练,然后将拼接好的模型在跨模态数据上继续预训练以及在不同任务数据上进行微调。

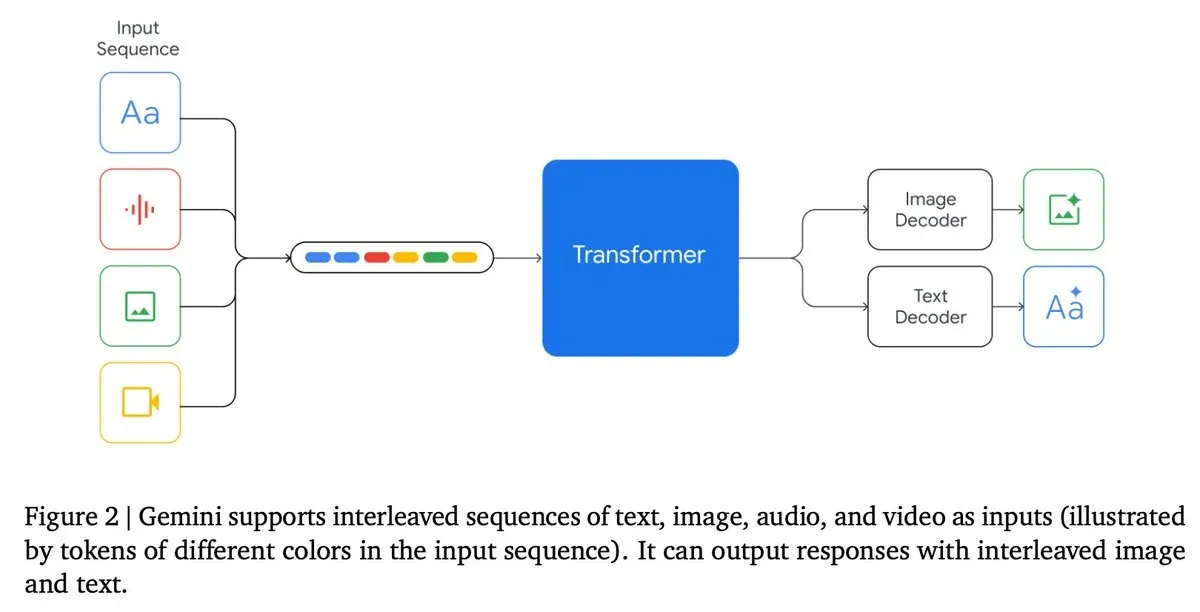

- 原生多模态大语言模型:从训练阶段开始,模型就利用大量不同模态的数据进行预训练,技术上实现紧密的耦合,不仅可以在输入和输出端实现多模态,而且还具备强大的多模态推理能力以及跨模态迁移能力。(进一步了解可参考 为什么说 GPT-4o 是原生多模态?GPT-4V 不是原生多模态么?)

真正意义上的原生多模态模型主要是 OpenAI 的 GPT-4o 和谷歌的 Gemini,将所有模态集成在一个端到端的模型中,GPT-4o 支持文本、音频和图像的任意组合输入与输出,ChatGPT 客户端支持像使用 Facetime 一样进行实时视频通话,而 Gemini 则能够理解和生成多种模态的数据,此外开发者还可以通过 Multimodal Live API 实现低延迟的双向语音和视频互动,并结合多种工具处理动态任务。

在多模态接口方面,月之暗面的 Kimi 是典型代表,支持图片和多种文件类型的上传及语音交互。Kimi 在长文本理解能力上个人体感依然处于国内模型的第一梯队,此外,还推出了专注于数学推理的 k0-math 模型,基于强化学习技术的视觉思考模型 k1 模型,以及提升 AI 自主搜索能力的 Kimi 探索版,但这家重心在 C 端,API 接口使用起来一言难尽,能提供的接口能力也有限。

Anthropic 家的模型自 Claude 2 发布以来一直是我主力使用的,后面写一篇文章来详细介绍)。

MiniMax 的海螺 AI、智谱的智谱清言和阶跃星辰的跃问也属于多模态接口类型,但部分模型又采用了对齐与融合的方案,比如图像理解是图片与文本模态对齐融合、实时语音是语音与文本模态对齐融合,不过这几家都提供了丰富的 API 支持。

| 模态类型 | 阶跃星辰 | 智谱 | MiniMax | 字节跳动 |

|---|---|---|---|---|

| 文本生成/理解 | step-2 | GLM-4 | abab7-chat | Doubao-pro |

| 图像理解 | step-1v | GLM-4V | abab7-chat | Doubao-vision |

| 图像生成 | step-1x-medium | CogView-3-Plus | - | Doubao-文生图模型 |

| 视频理解 | step-1.5v-mini | GLM-4V-Plus | - | Doubao-vision |

| 视频生成 | Step-Video | CogVideoX | video-01 | Doubao-视频生成 |

| 语音克隆和生成 | step-tts-mini | - | speech-02 | Doubao-声音复刻/语音合成 |

| 语音识别 | step-asr | - | - | Doubao-语音识别 |

| 实时语音(端到端) | Step-1o | GLM-4-Voice | Realtime API | - |

对于零一万物和百川智能两家的产品,由于未使用过,暂不作评价,字节跳动的文生图模型表现出色,尤其在中文语义理解方面非常强大,但其价格较高(0.2 元/次),通义千问开源的底模用起来很强,但 C 端产品用起来明显感觉阉割过度了,基本不用。

开源模型

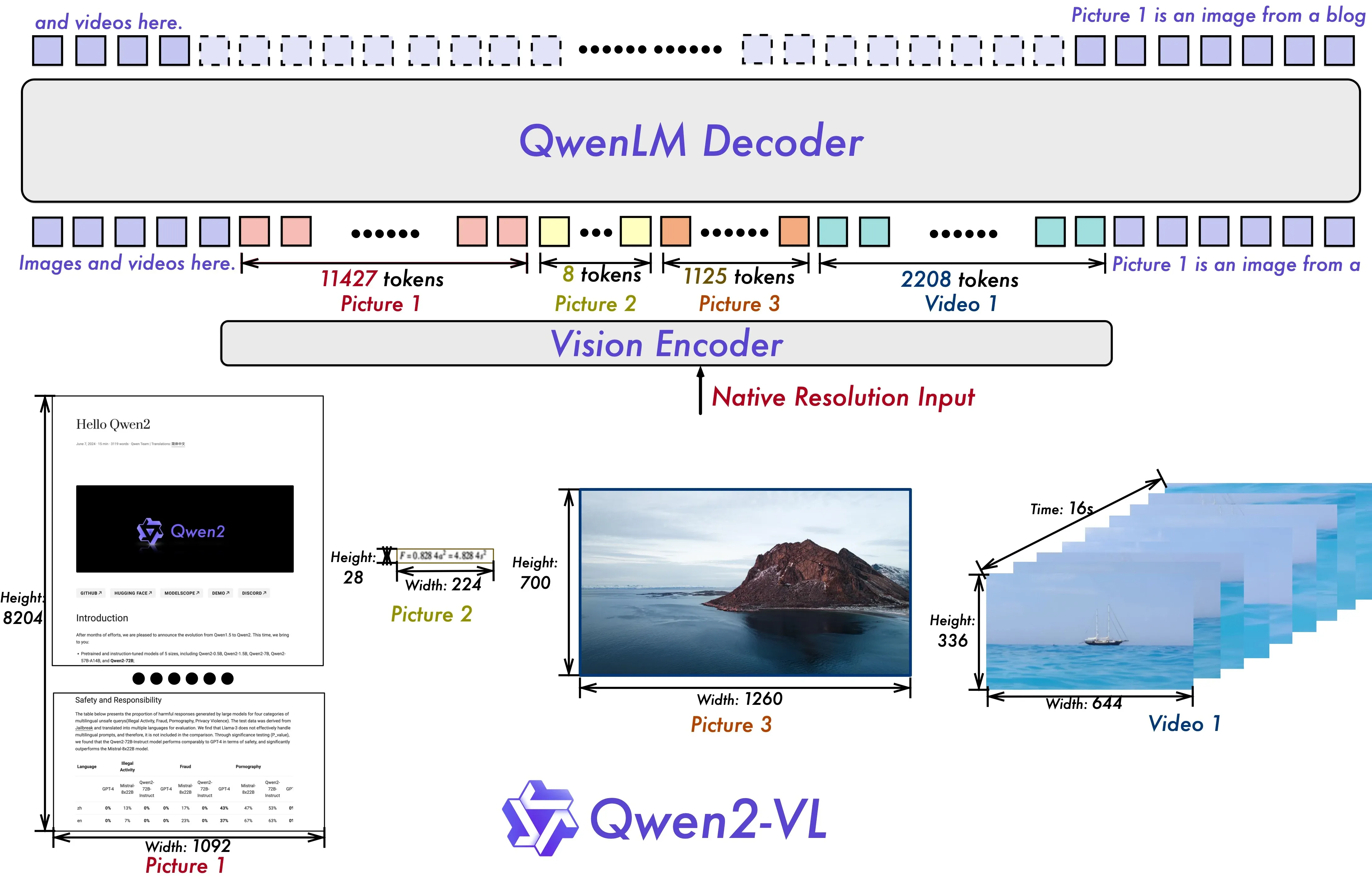

开源模型主力军是 Llama、Qwen、Mistral AI、DeepSeek 四家,主要还是聚焦在模型基础能力方面的提升, Qwen 系列模型,包括 Qwen 1.5、Qwen 2 和 Qwen 2.5,提供了多种规模的模型选择,并在性能、多语言能力、上下文长度和安全性方面进展迅速,此外,Qwen 还推出了专门针对视觉语言、多模态推理、音频处理的模型,如 Qwen2-VL、QVQ-72B-Preview 和 Qwen2-Audio,进一步扩展了模型的应用范围。Llama 系列模型,从 Llama 3 开始,到 Llama 3.1、Llama 3.2 和 Llama 3.3,在参数规模、上下文长度和性能上不断突破,特别是 Llama 3.1 405B 版本成为了最大的开源大语言模型之一。DeepSeek 推出包括 DeepSeek LLM、DeepSeek-Coder、DeepSeekMath、DeepSeek-VL、DeepSeek-V2、DeepSeek-Coder-V2、DeepSeek-VL2 和 DeepSeek-V3 等模型,在多语言、代码生成、数学推理方面展现了卓越的能力,在性能和效率上都取得了显著的提升,而且在成本和性能之间取得了平衡。Mistral AI 也开源了 Mistral Large、Mistral Small、Pixtral Large、Mixtral 8x22B、Mistral NeMo、Codestral Mamba 和 Mathstral 等模型,在多模态处理、编程任务和数学问题等方面表现出色。(详细可以阅读我的博客 开源大模型年终盘点:Llama、Qwen、Mistral AI、DeepSeek )

其中生态比较繁荣要属 Qwen 和 LIama 系列了,多模态的探索也聚焦在多模态对齐与融合方案上,把不同的单个模型拼接起来使得模型具备多模态能力,比如 Qwen-VL,它就是 Qwen-7B + Openclip ViT-bigG(2.54B)的结构,前者作为基础语言模型,后者作为视觉模型,因此 Qwen-VL 也支持图像、文本多模态输入。

AIGC 模型

专用多模态模型领域中,在音乐生成方面,Suno V3 被誉为“音乐界的 ChatGPT”,它支持生成 2 分钟长度、广播质量级别的音乐,并且对提示词的理解更深,使得普通人也能轻松生成自己想要的音乐,Seed-Music 是字节跳动推出的音乐生成大模型,将用户录制的 10 秒音频转化为完整的音乐作品,可以根据用户的输入(如风格描述、音频参考、乐谱和声音提示)生成高质量、风格可控的音乐。在视频生成模型方面,快手于 6 月正式发布 AI 视频大模型“可灵”,能够生成逼真的人类角色和动态场景,MiniMax 在 8 月正式发布视频生成模型 abab-video-1,国外市场上 Runway 推出了新一代视频生成模型 Gen-3 Alpha,具有更高的保真度和一致性,Luma Labs 的 Dream Machine 能够快速从文本和图像生成高质量、逼真的视频。开源社区也紧随其后,从潞晨科技的 Colossal-AI 团队最早开源的 Open-Sora 1.0 ,到智谱 AI 的 CogVideoX, Genmo 开源的 Mochi 1,主打快速生成视频的 LTX-Video,再到腾讯发布混元视频生成大模型,极大缩小了与商业模型的差距。在图像领域,文生图模型 Flux 因其出色的图像生成质量和对提示词的高遵循度,迅速受到关注,社区推出了众多效果出色的 LoRA 模型,而 ComfyUI 凭借灵活编排能力支持带来的高度扩展性,提高应用可能性,影响力也逐渐超过了 Stable Diffusion WebUI ,初次之外,AI 实时生成游戏画面、AI 3D 生成领域也快速发展,不过没有重点关注。

小模型

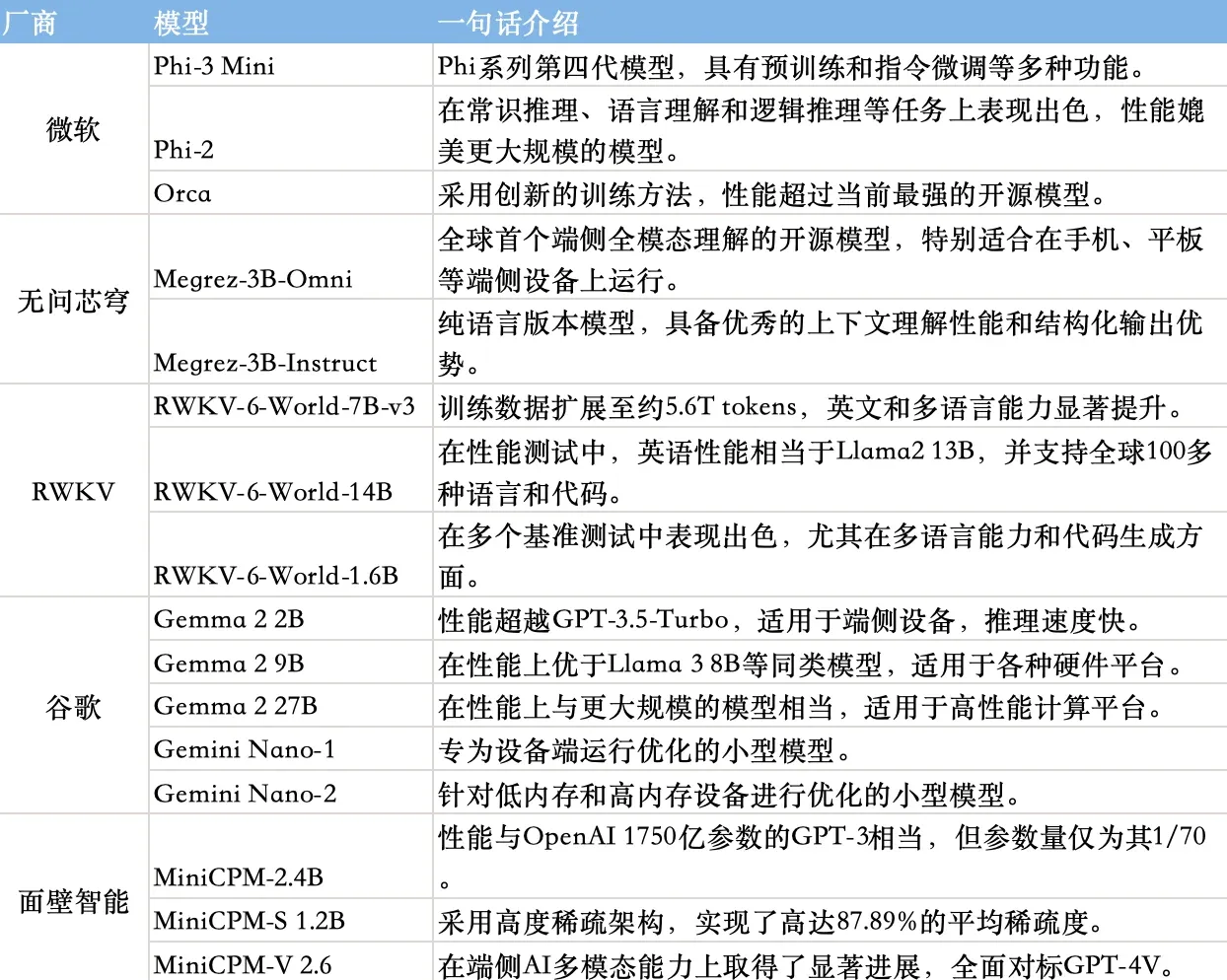

毕竟搞大模型的公司占据了太多头条,亮眼到大家可能会忽视小模型的进展,小模型其实发展的也很快,除了搞大模型开源的 Llama、Qwen、Mistral AI 和 DeepSeek 同时在搞小模型外,一些大厂和专门搞小模型的厂商也推出了多样化的小模型以适应不同应用场景。

小模型的根据适用场景,参数可以分为四个区间,0.5B 参数量适合耳机、眼镜等轻量级外设;3-7B 参数量适合手机等移动端设备;14B 参数量适合个人开发者 PC;72B 参数量适合科研机构和企业。

微软的 Phi 系列模型(如 Phi-3 Mini 和 Phi-2)虽然参数量小,但在特定任务上表现出色,无问芯穹的 Megrez-3B 系列模型,尤其是端侧全模态理解开源模型 Megrez-3B-Omni,非常适合在移动设备上运行,RWKV 系列模型参数量从 0.14B 到 1.4B 不等,在小说写作、长期记忆保持等方面表现出色,谷歌的 Gemma 2 系列模型覆盖从 2B 到 27B 参数,适应不同硬件平台上,而且 Gemini Nano 模型已内置于 Chrome 浏览器中,面壁智能的 MiniCPM 系列模型以较小的参数量实现了与大模型相媲美的性能,特别是在端侧多模态能力上取得了显著进展,这些小模型在资源效率和特定场景应用中展现出明显优势。

大模型和小模型将各自擅长领域发挥独特作用,大模型将继续在需要广泛知识基础和高级认知能力的领域中占据核心地位,而小模型则以其轻巧高效的特点,在成本敏感、对响应时间有严格要求的应用场景中大放异彩。

推理模型

o1 模型的推出标志着模型研究进入了一个新的范式,这可能是 OpenAI 决定不再沿用 GPT 系列命名的原因,当然也为头部玩家开辟了一个新的可以卷的赛道,例如,智谱的 GLM-Zero、Deepseek 的 R1-Lite、Kimi 的视觉思考版、阿里的 QWQ 32B 和 QVQ,以及 Gemini-2.0 Flash Thinking Exp 等模型都在紧追不舍。我在文章《OpenAI o1 模型很强?别急,离 AGI 还早着呢!》中曾质疑这种路径是否只是让模型成为解决特定问题的超级“做题家”(必须有明确的 RM),毕竟当年深蓝在国际象棋战胜人类冠军(1997 年),当时给人的震撼不比这次 o1 模型发布小。

当 o3 模型发布时,包括我自己在内的许多开发者已经难以准确感知报告中那些衡量智能的数据指标了(起码这些数据超出了我自己对智能的理解,我都在想我写的关于 o1 的文章可能就是一派胡言),我觉得接下来如何设计评估基准,如何衡量模型能力都是非常有挑战的事情,我毫不怀疑当有一天真正的 AGI 来时,绝大多数普通人是浑然不知的。

开发者工具生态

这是我一直重点关注的领域,不仅因为我的职业角色要求我必须深入了解这些工具(无论是作为开发者还是技术顾问),还因为它为观察 AI 的实际应用提供了一个重要的窗口,微软、谷歌等公司以及许多 AI 开发者都在使用这一成熟的工具,这些工具必然在工程化利用 AI 时解决了诸多关键问题,开发者工具自下而上涵盖了模型托管与推理服务、代理工作流编排、大模型应用的监控与追踪、模型输出的可控性以及安全工具等多个方面。

模型托管与推理服务

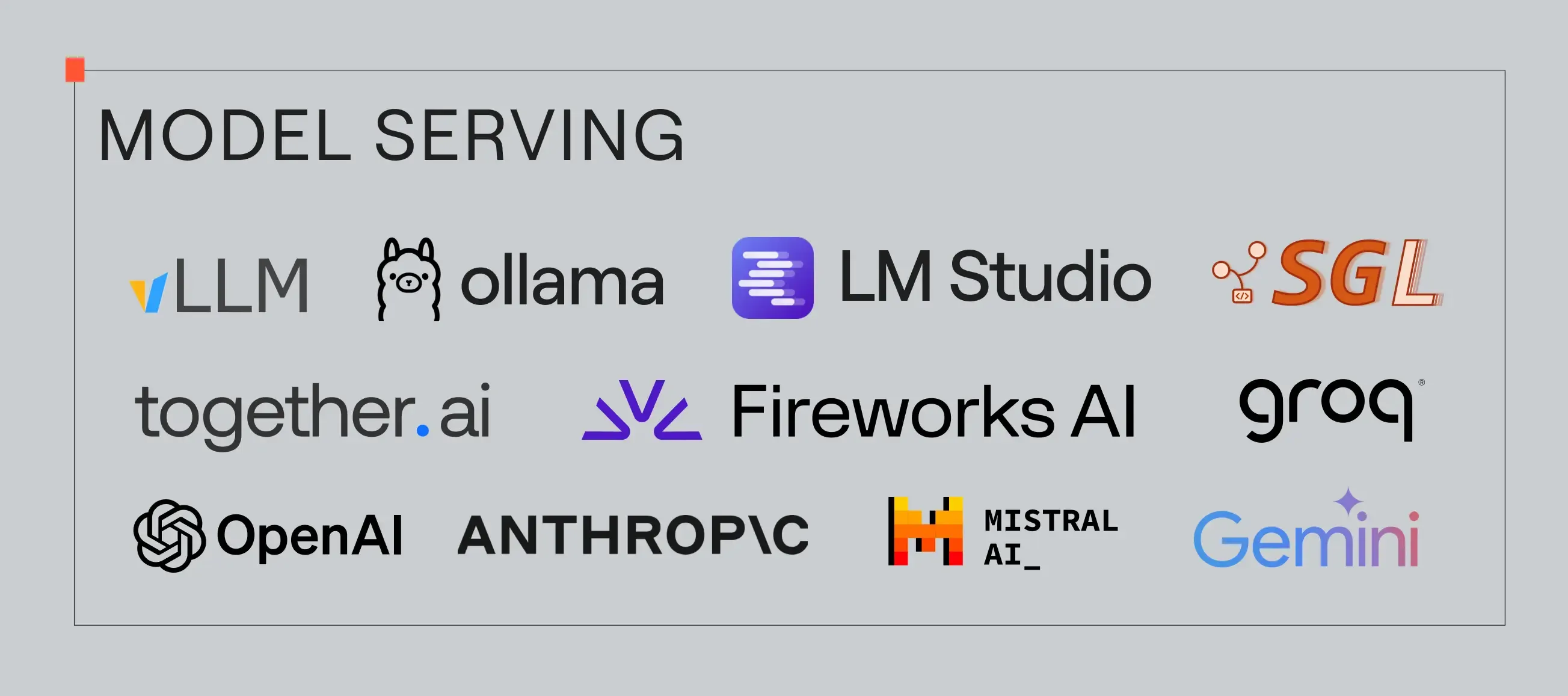

模型是 AI 应用的核心组成部分,其服务需依赖推理引擎实现。开发者接入模型的方式大致可分为四类:首先是以模型初创企业为代表,提供先进的商业闭源模型,如 OpenAI、Anthropic、智谱及 MiniMax 等;其次是由 TogetherAI、Groq、Fireworks、Replicate、硅基流动等组成的 GPU 推理集群服务提供商,它们处理扩展与缩减等技术难题,并在基本计算费用基础上收取额外费用,从而让应用公司无需承担构建和管理 GPU 推理集群的高昂成本,而是可以直接利用抽象化的 AI 基础设施服务;第三类是传统的云计算平台,例如亚马逊的 Amazon Bedrock、阿里云百炼平台、微软的 Azure AI、谷歌 Vertex AI 等,允许应用开发者轻松部署和使用标准化或定制化的 AI 模型,并通过 API 接口调用这些模型;最后一类是本地推理,SGLang、vLLM、TensorRT-LLM 在生产级 GPU 服务负载中表现出色,受到许多有本地托管模型需求的应用开发者的欢迎,此外,Ollama 和 LM Studio 也是在个人计算机上运行模型的优选方案。

还有三家在硬件层面支持推理加速的初创公司值得关注,SambaNova 通过动态可重构数据流架构的芯片,提供高效的 AI 模型推理能力,Groq 和 Cerebras 通过使用大容量片上 SRAM 来优化推理速度。

应用层工具

除模型层面外,应用层面的工具同样在快速发展,工具的进步紧密跟随 AI 应用的发展趋势。自 ChatGPT 发布以来,应用构建方式大致经历了三个阶段:首先是基于单一提示词模板的聊天助手类应用,此阶段重点关注模型和提示词的安全性以及模型输出的可控性。例如,garak 可用于检测模型幻觉、数据泄露和生成毒性内容等问题;rebuff 则针对提示词注入进行检测;DSPy 框架提供了系统高效的编程方法,帮助解决应用开发中的提示编写问题;而 LM Format Enforcer、Guidance 及 Outlines 等项目旨在帮助开发者控制模型输出的结构,以获得高质量的输出。

第二个阶段涉及通过组合一系列提示词和第三方工具或 API 来编排复杂的工作流,这是目前成熟的 AI 应用构建思路之一。值得注意的是,RAG 技术的出现,得益于大语言模型天然适合处理知识密集型任务,RAG 通过从外部记忆源检索相关信息,不仅提高了模型生成的精确性和相关性,还解决了大语言模型在数据隐私保护、实时数据处理和减少幻觉问题等方面的局限。RAG 技术在数据预处理和索引构建方面的努力,直接影响最终应用的效果。尤其是在本地数据预处理方面,PDF 内容处理成为一大难点,众多开源项目应运而生,如基于传统 OCR 技术和版面分析的 Unstructured 和 Marker 库,以及结合了多模态大模型识别能力的 ZeroX 和 GPTPDF 库。此外,还有融合了 OCR 和多模态大模型方案的 PDF-Extract-API 库。在公开在线数据处理方面,Jina Reader、Crawl4AI 和 Markdowner 等开源项目,能够将网页内容转换成适合大模型处理的上下文,从而利用最新信息提升问题回答的质量。这些项目的共同目标是将原始数据转化为有价值的资产,助力企业大规模部署 AI。

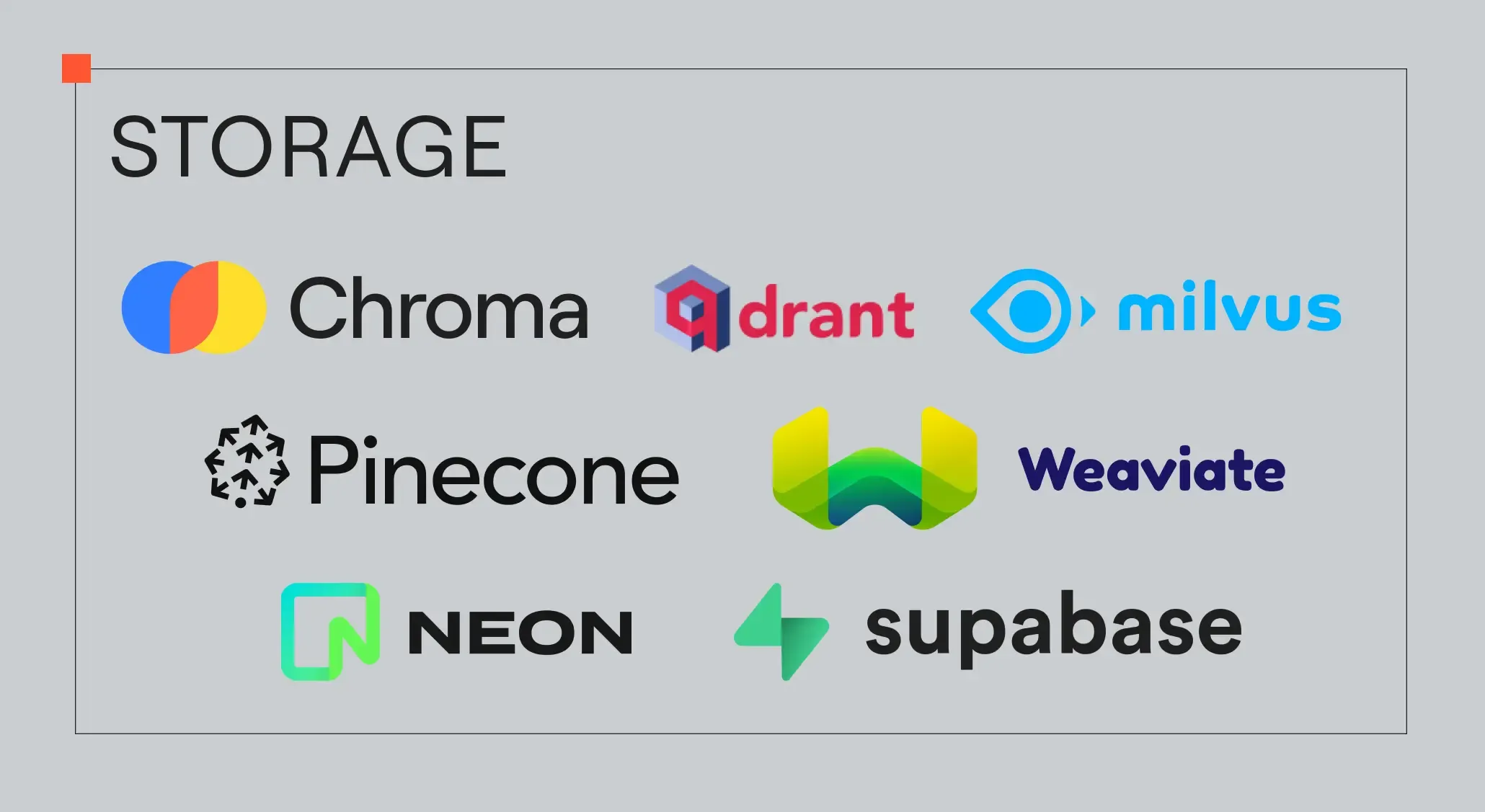

对于结构化数据,如对话历史记录和其他数据源的存储管理同样重要。向量数据库如 Chrom、Weaviate、Pinecone、Milvus 等,提供了语义检索和向量存储功能,使得 AI 应用能够利用超出模型上下文限制的数据源。传统数据库 PostgreSQL 现在也支持通过 pgvector 扩展进行向量搜索,基于 PostgreSQL 的公司如 Neon 和 Supabase 为 AI 应用提供了基于嵌入的搜索和存储解决方案。

为了有效管理 AI 应用的复杂工作流程,市场上涌现了 Dify、Wordware、扣子等低代码平台,它们集成了多种大模型,支持外部数据接入、知识库管理和丰富的插件库,通过拖拽式配置帮助初学者快速构建 AI 应用。同时,在开源生态系统中,LangChain、Haystack、Semantic Kernel 等编排框架的出现,使开发者能够构建、定制和测试 Pipeline,确保这些 Pipeline 的组合能够达到特定应用场景的最佳生成效果。对于 RAG 应用,这是一种由多个环节构成的工作流应用,出现了许多端到端的开源解决方案,如 LlamaIndex 框架,它集成了数据预处理、索引构建、多样化检索方法等功能,专为大语言模型设计;RAGFlow 是一个基于深度文档理解的开源 RAG 引擎,提供高质量的问答能力,适用于处理大规模的复杂格式数据;Verba 是向量数据库厂商 Weaviate 开源的一个模块化 RAG 框架,允许开发者根据不同的应用场景灵活定制 RAG 应用的不同环节。

代理构建

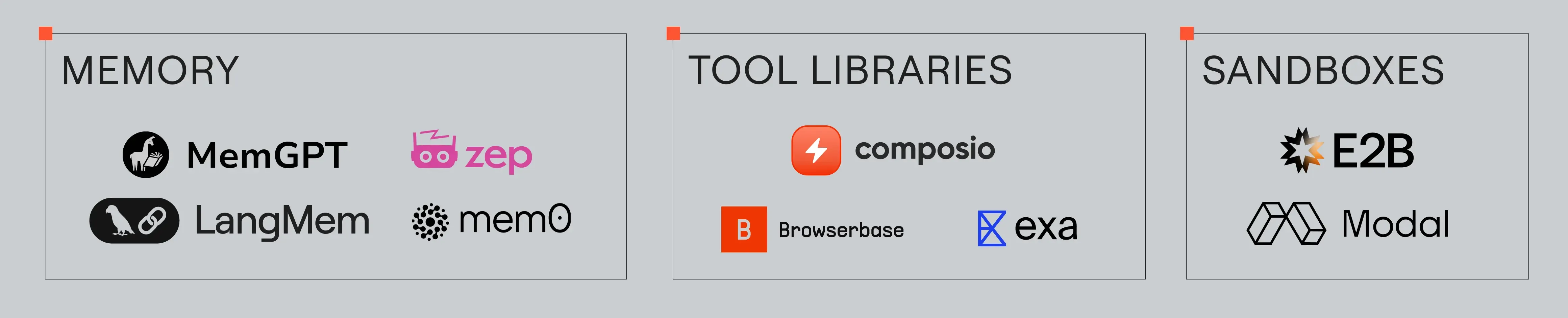

第三个阶段,一些产品团队正探索开发完全由大模型驱动的代理应用。这类代理应用具备从历史记忆中反思、自主规划和使用工具执行特定动作的能力。大语言模型负责选择要调用的工具及其参数,而具体的执行动作则在沙箱环境中进行,以确保安全。E2B、Modal 等服务提供商正是为了满足这一需求而诞生。代理通过 OpenAI 定义的 JSON 模式调用工具,这使得代理和工具能够在不同的框架中兼容,促进了代理工具生态系统的增长。例如,Composio 是一个支持授权管理的通用工具库,Exa 则提供了一个专门用于网络搜索的工具。随着更多代理应用的构建,工具生态系统将持续扩展,提供更多新功能,如认证和访问控制。

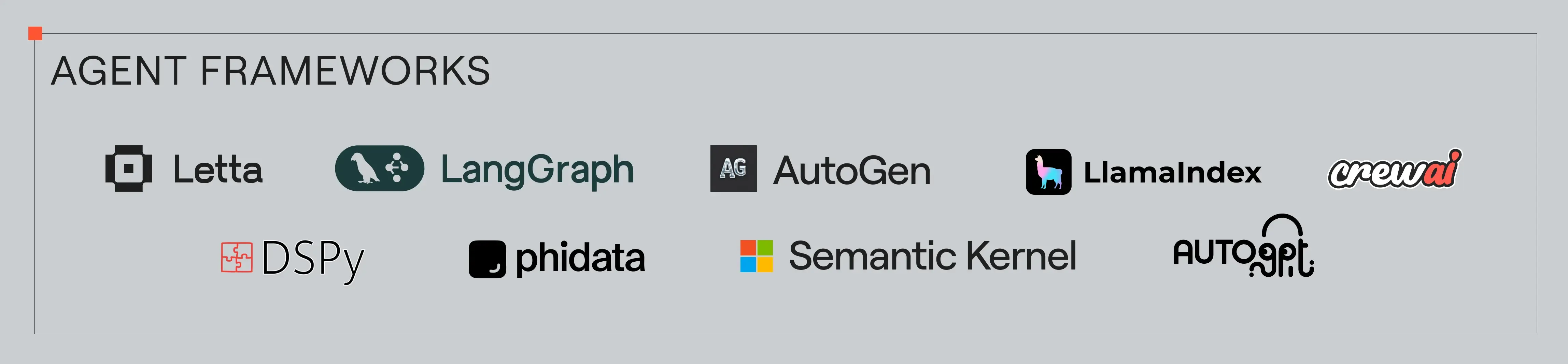

在代理应用中,记忆管理同样关键。开源项目 Mem0 将记忆分为短期记忆和长期记忆,后者进一步细分为事件记忆、语义记忆和程序记忆,并基于此抽象出一套记忆管理 SDK。Zep 通过时态知识图谱管理和更新用户信息,跟踪事实变化并提供最新数据线索。MemGPT 借鉴了计算机操作系统内存管理机制,模拟虚拟内存工作原理,构建了一套记忆管理系统。这些项目使 AI 应用能够记住对话历史,提供更个性化、上下文感知的交互体验,极大地增强了用户的满意度。此外,代理应用的另一个探索方向是多个代理之间的协同工作。开源社区中出现了许多解决方案,如 CrewAI 和 AutoGen 具备原生的多代理通信抽象,而 LangGraph 和 Letta 中的代理可以互相调用,良好的多代理系统设计使得跨代理协作变得更加容易实现。

应用监控与追踪

鉴于生成模型本质上是一个概率黑盒,AI 应用作为一个复杂的系统,其在生产环境中的质量评估与监控尤为重要。实际应用中最大的挑战之一就是输出结果的不确定性。面对这些挑战,需要采用科学的评估方法。LangSmith、Arise、Langfuse、Ragas 和 DeepEval 等项目提供了评估和监控所需的各种指标和工具,帮助开发者量化测量、监控和调试他们的 AI 应用系统。

2025 年关注方向

这不是宏观上预测的一些”正确的废话”,说点具体的事项,也是我确实会持续关注和花时间计划投入的。

- 实时 API 成本下降:目前实时 API 的价格仍然较高,肯定还会下降一个数量级,成本下来后做 Realtime Voice 方向的产品尝试(推荐关注前 FixieAI CTO Justin Uberti 的博客和动态,特别是关于 Realtime Voice 方向进展)

- Agent Network 协议的发展:虽然 MCP 协议生态以模型为中心,但我更关注广义上的 Agent 互联互通协议。开源社区和标准化组织(如 AutoGPT 团队的 Agent-Protocol、W3C 的 WebAgents 工作组)都在积极推动这一领域的发展,此外,Eliza 项目通过加密货币构建了 Agent 之间的经济系统。

- Anthropic 模型更新:Anthropic 家模型,我一直很关注,Claude 3.5 Opus 肯定会出,就看是不是原生多模态,同时提供 Realtime API 了,发布对标 OpenAI 的 o 系列的推理模型,在此基础上升级产品体验。

- AI 硬件产品爆发:AI 概念的硬件爆发,实时翻译耳机和智能眼镜等,虽然 2024 年华强北的水下产品已经不少了,这类产品的成熟度值得期待,届时可以考虑购买几款进行体验。

- 强化学习定义的成熟 Agent 产品:首个真正符合强化学习定义的成熟 Agent 产品出现,或许是 Devin?达到 5000 万美金 ARR。

- 视频生成模型的进步:看好 2025 年视频生成模型实现更好的可控性和一致性,能够完整制作剧情连续短片。

- 平台规则条例出台:社交平台将出台详细的规则,能够识别并明确标识 AI 生成的内容(希望它们能科技向善?)。

- 祝福与展望:凑个数,祝读者朋友们 2025 年开发的 AI 产品赚大钱。