Vol.13:如何验证模型是否被测试集污染?

⼤家好,Weekly Gradient 第 13 期内容已送达!

论文部分介绍了一种无需访问预训练数据或模型权重即可验证测试集污染的方法,通过对模型的测试问题进行有序和无序的展示,观察似然概率的统计显著差异来检测数据污染。同时,介绍了对话代理框架的提出,该框架能够实现对话控制和规划最优对话行动,以及提高 RAG(Retrieval-Augmented Generation)模型性能的 RankRAG 指令微调框架。最后,介绍了 NL2SQL 的 RB-SQL 框架,用于提高大型数据库和复杂多表查询的处理能力。

工程部分讨论了知识助手的未来发展趋势,包括 Agentic RAG 的流程和 PE-Rank 的开源,以及开源 TTS 项目的整理和评估。同时,提到了 Open AI 研究员 Lilian Weng 的文章,完整探讨了 LLM 产生幻觉的原因、检测方法和防止幻觉的方法。

产品部分展示了 Anthropic Console 的新功能,能以生成、测试和评估 prompt,以及 DeepSeekMath 这款数学推理能力接近 GPT-4 的 7B 模型。还提到了 Nexa AI 提供的 AI Agent 解决方案,以及 LanceDB 这种为 AI 多模态数据设计的数据库。

市场部分分析了 AI 医疗产业的发展现状和趋势,探讨了从云计算到大模型时代的数据库行业竞争,以及 OpenAI 推出的 AGI 五级路线图。

✉️ 免费订阅更新

订阅我的免费通讯,第一时间获取生成式 AI 领域优质内容

我承诺保护您的隐私,不会向第三方分享您的信息。

您可以随时取消订阅。

论文

证明黑盒语言模型中的测试集污染:大模型在海量互联网数据上进行训练,引发了人们对它们可能已经记住公开基准测试数据的担忧和猜测。然而,从猜测到证明数据污染是一个具有挑战性的过程,因为专有模型使用的预训练数据通常无法公开访问。这篇论文证明了无需访问预训练数据或模型权重,就能提供测试集污染的可证明保证。论文方法利用了这样一个事实:假设模型记住问题和答案的顺序与它们在测试数据集中出现的顺序相同,然后观察如果向模型展示一组测试问题,按照它们在数据集中出现的顺序或按打乱的顺序,我们是否可以建立似然概率的统计显着差异。作者通过将测试数据(BoolQ、HellaSwag、MMLU 等)添加到训练集(Wikitext)中来训练 1.4B GPT-2,并表明在训练集中使用 4+ 份测试数据重复可以可靠地测量数据污染。他们进一步检查了 llama-2、mistral 和 pythia 模型,并表明这些模型通常不在测试数据上进行训练,但有一个用例除外,即 Mistral-7B 在 Arc-Easy 数据集上进行训练的可能性非常高。

Planning with Large Language Models for Conversational Agents :自主对话代理的核心在于可控性与主动性,可控性意味着需遵循标准操作流程,如激活信用卡前的身份验证;主动性则要求在用户不配合时引导对话达成目标,如进行说服性交流。这篇论文提出基于大模型驱动的对话代理框架,在人类设定任务与目标的基础上实现对话控制,LLM 离线制定关键 SOP,并在线依据 SOP 规划最优对话行动,确保对话可控性。构建半自动对话数据生成框架,创建高质量对话数据集)。研发多种对话代理框架变体及评估标准,如采用蒙特卡洛树搜索的规划方法,寻找最优对话策略,增强对话主动性。

RankRAG: Unifying Context Ranking with Retrieval-Augmented Generation in LLMs:论文提出了名为 RankRAG 的创新指令微调框架,可同时进行上下文排序和答案生成,显著提升了 RAG 的性能。通过融入少量排序数据,RankRAG 不仅超越了专门优化的排序模型,在生成任务中表现卓越,击败了包括 GPT-4 在内的多个顶尖模型。特别是在知识密集型和生物医学领域的基准测试中,RankRAG 展现了强大的泛化能力,无需特定领域的微调即可与 GPT-4 媲美。

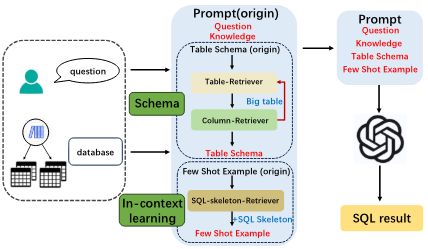

RB-SQL: A Retrieval-based LLM Framework for Text-to-SQL:NL2SQL 的目标是将自然语言问题转化为 SQL 查询,从而检索数据库中的答案。目前,LLM 在指导 SQL 生成方面在处理大型数据库和复杂多表查询时面临挑战,尤其是在处理冗余信息和提高提示工程效率方面。为了解决以上问题,这篇论文提出了 RB-SQL 框架,包含三个模块:Table-Retriever 用于检索相关表格,Column-Retriever 用于进一步检索相关列,SQL-Skeleton-Retriever 用于搜索相似 SQL 骨架的少量示例,增强上下文学习过程。

工程

知识助手的未来:LlamaIndex CEO 在 AI Engineer 上的主题演讲,Agentic RAG 是当前比较好的方案,至于 Talk 末尾提到 RAG 也会向 Multi-Agent 架构发展,就有点为了优化而优化。

带推理的 RAG Flow 分成四种主要的基础模式:顺序、条件、分支与循环,下面是一个 Agentic RAG 例子:

- 根据问题,路由器决定是从向量存储中检索上下文还是进行网页搜索。

- 如果路由器决定将问题定向到向量存储以进行检索,则从向量存储中检索匹配的文档;否则,使用 tavily-api 进行网页搜索。

- 文档评分器然后将文档评分为相关或不相关。

- 如果检索到的上下文被评为相关,则使用幻觉评分器检查是否存在幻觉。如果评分器决定响应缺乏幻觉,则将响应呈现给用户。

- 如果上下文被评为不相关,则进行网页搜索以检索内容。

- 检索后,文档评分器对从网页搜索生成的内容进行评分。如果发现相关,则使用 LLM 进行综合,然后呈现响应。

Jina AI 开源 PE-Rank:Jina AI 继 Reranker v2 之后,又开源了 PE-Rank,一种新的基于 LLM 的段落重新排序器,采用列表式段落高效排序,不直接输入原始文本到 LLM,而是用嵌入模型表示每个段落为特殊标记,再将[指令]+[查询]+[特殊标记]输入 LLM。PE-Rank 限制推理输出在特殊标记上,提高解码效率,PE-Rank 将 100 个文档重新排序的延迟从 21 秒减少到 3 秒。

能用得上的、有商用价值的才算是一个好的开源项目,这个是开源 TTS(文本转语音)项目整理:

- fish-speech:声音克隆功能对中文效果不错,但生成长音频效果和英文支持度有待改善。

- ChatTTS:支持多语种和多发音人,可控制笑声、停顿和语调细节,但准确性有限,仅支持中英文,参数调整可能导致语音差异。

- mars5-tts:仅需 2-12 秒的参考音频,支持深浅度克隆选项,情感更加逼真。只支持单人音频克隆,无法实现对话。

- GPT-SoVITS:声音克隆功能,通过 1 分钟微调训练数据即提升声音相似度和真实感。输入 5 秒音频,立即体验文本到语音转换。支持中英日,适应不同语言环境和声音需求。在 Mac 上 GPU 训练模型效果不如其他设备。本地运行,无需联网,这个我试用下来效果不错。

- IMS-Toucan:纯 Python 和 PyTorch 编写的文本转语音系统支持 7000 种语言和方言,具备人机编辑功能,可根据需求对合成语音进行微调。安装和配置可能复杂,尤其在非 Linux 系统。

- OpenVoice:支持声音克隆,包括调节情感、说话风格和停顿。支持商用,但中文效果较差。

Extrinsic Hallucinations in LLMs:Open AI 研究员 Lilian Weng (就是定义那个 LLM-base Agent 架构的研究员)新文章,完整探讨了 LLM 产生幻觉的原因、检测方法和防止幻觉的方法,可以看做这个领域工作的综述,有学术有工程部分,非常全。

产品

Anthropic Console 添加了新功能,可以生成、测试和评估 prompt:Claude 做的真的越来越好了,输入任务描述,Claude 3.5 Sonnet 将把任务描述转换为高质量的 prompt,如果用户有了 prompt,可能需要一些测试用例来运行它,Claude 还可以生成相应的测试用例。用户可以根据需要修改测试用例,并一键运行所有测试用例,还可以查看并调整 Claude 对每个变量生成要求的理解,以实现对 Claude 生成测试用例更细粒度的控制,Anthropic 还按照 5 分制为 Claude 响应质量设置了评分。我一直认为来自社区的提示词工程师对提示词的技巧应用的再好,那也是在黑盒基础上的一种尝试性探索,没有人比模型研发团队自己对模型理解的更清楚(否则只是糊里糊涂按照经典架构训练出来而已),怎么用提示词,怎么更好挖掘模型的能力必须是模型团队亲自下场带大家做探索。比如让生成“零售或餐饮行业的数据分析助手”的提示词,大家可以感受下。

你是一名人工智能助手,负责为零售或餐饮企业提供消费者洞察和运营建议。您的目标是分析店铺数据,将其与零售和餐饮专业知识相结合,并提供有价值的见解和可行的建议,以改善业务运营。 首先,您将获得店铺数据。这些数据可能包括销售数字、客户人口统计、热门产品、高峰时段和其他相关指标等信息。以下是店铺数据:

仔细分析这些数据,找出趋势、模式和潜在的改进领域。

请考虑以下因素:

- 销售业绩 2. 客户行为和偏好 3. 产品受欢迎程度和盈利能力 4. 运营效率 5. 季节性趋势或波动

接下来,将您的分析与一般零售和餐饮专业知识相结合。考虑以下方面的最佳做法: 1. 店铺布局和产品摆放 2. 客户服务和体验 3. 库存管理 4. 营销和促销 5. 员工安排和培训 6. 菜单设计(餐饮企业)

根据您的分析和专业知识,针对提出的具体问题或疑虑提供运营建议。

问题如下:

在撰写回复时,请遵循以下指导原则: 1. 首先简要概括商店数据中的关键信息。 2. 直接针对问题提供具体可行的建议。 3. 解释建议背后的原因,将建议与数据洞察和行业最佳实践联系起来。 4. 如果适用,提出在实施建议时可能遇到的挑战或需要考虑的因素。 5. 酌情提供 2-3 个备选策略或解决方案。

以清晰、专业的方式介绍您的分析和建议。适当时使用要点或编号列表,以提高清晰度。您的回复应详尽而简洁,一般在 300 到 500 字之间。

以

开头,以 结尾。在回复中,使用适当的小标题将数据见解与操作建议明确分开。 切记根据具体的业务类型(零售或餐饮)和所提的具体问题来调整您的建议。您的目标是提供有价值的实用见解,帮助企业改善运营和绩效。

DeepSeekMath:一个 7B 模型但有逼近 GPT-4 的数学推理能力: Kaggle 社区上进行的全球首届人工智能数学奥林匹克竞赛(AIMO)于近日公布了进步奖获奖名单,获奖的 Top4 团队都选择了 DeepSeekMath-7B 作为基础模型,并且取得了很不错的准确率。

- 第一名提交的最佳方案是用 SFT 和在线强化学习算法 KTO 混合微调 deepseek-math-7b-base。

- 第二名微调了两个 DeepSeek-Math-7B-RL 模型,一个用作策略模型(生成答案),另一个作为奖励模型,对回答进行评分以调整答案的顺序。

- 第三名使用了未经微调的 DeepSeek-Math-7B-RL 模型,并通过制定的评分规则使用多数投票的策略选择正确答案。

- 第四名使用了 DeepSeek-Math-7B-RL,参数设置为:温度 0.9,top_p 为 1.0,最大 Token 数 2048。此模型结合了代码工具,在 MATH 基准测试中能达到 58.8% 的准确率。

Nexa AI:云端模型的第一个问题是延时问题;第二个问题是用户隐私,用户可能不愿意将他们的私人数据(如聊天记录)上传到云端模型,因为这涉及到隐私泄露的风险;第三个问题是成本问题,云端模型的 API 服务通常需要付费,比如微软已经下架了 Copilot 的 GPTs 版本,原因可能是成本过高,入不敷出。对于硬件厂商(如手机厂商)来说,云端模型的延时、隐私和成本问题是一个痛点,他们想要的是,利用用户的本地算力来运行模型,这样既可以保护用户隐私,又可以快速响应用户需求,同时避免了 API 调用的成本。Nexa AI 是一家致力于提供更快、更智能的 AI Agent 公司,近期刚刚在海外完成一轮 1500 万美金的融资。Nexa AI 的 AI 代理速度比 OpenAI GPT-4o 快 4 倍,成本比其他领先模型低 10 倍,任务完成的准确性高出 5 倍。

LanceDB:LanceDB 是为 AI 多模态数据设计的数据库,目前的客户包括 MidJourney、Character AI 等。他们设计了开源数据格式 Lance,以解决传统数据格式 Parquet 不适合大规模非结构化数据的问题。基于 Lance 格式构建的多模态向量数据库 LanceDB 能够以更低的成本、更快的速度索引数十亿向量和 PB 级别的文本、图像和视频数据。

市场

2024 中国 AI 医疗产业研究报告:AI 正在迅速渗透医疗行业的各个环节,包括但不限于影像诊断、药物研发、临床决策支持、健康管理等。AI 医疗的价值体现在提升医疗服务质量、增加医疗服务可及性以及降低医疗成本上,甲子光年推出《2024 中国 AI 医疗产业研究报告》,深入分析了 AI 技术在医疗产业中的应用现状、发展趋势、面临的挑战以及未来机遇。

从云计算到大模型时代,“AI 很难颠覆传统数据库”:Snowflake 即将举办的用户大会上,将发布最新的 AI 产品,Snowflake 之前开源的的 Arctic,以 128 位专家和 4800 亿参数,成为迄今最大的开源模型;Databricks 把品牌变成了 Data + AI,传统数据库领域巨头都在尝试转型,本文是 RisingWave(一款分布式流式数据库,可以实时处理数据并提供数据洞察)创始人对 AI 时代下数据库行业竞争的思考。

因为数据库公司相较于纯 AI 公司,更有实力去做这件事。AI 模型需要数据,而数据存在数据库或者 Data Warehouse。因此,数据库公司在帮助用户更好地了解自己的数据方面,具有很大的优势。

中国 AGI 市场发展研究报告:InfoQ 出品的报告,AI 在当前国内市场中的应用情况,特别是在营销、金融、教育、零售以及企业服务等关键行业领域,看了下报告出品团队都是一些一线的技术负责人,对各个行业当前落地的难点以及目前大模型能力局限的讨论很值得一看。

OpenAI 推出 AGI 五级路线图:来源于彭博社消息,OpenAI 制定了一个 5 级路线图表来展示他们向 AGI(人工通用智能)的进展:

L1:Chatbots,聊天机器人,具有对话能力的 AI。

L2:Reasoners,推理者,像人类一样能够解决问题的 AI。

L3:Agents,智能体,不仅能思考,还可以采取行动的 AI 系统。

L4:Innovators,创新者,能够协助发明创造的 AI。

L5:Organizations,组织者,可以完成组织工作的 AI。

Vol.13:如何验证模型是否被测试集污染?