Vol.19:AI应用正在这4个大场景里加速落地

⼤家好,Weekly Gradient 第 19 期内容已送达!

✉️ 免费订阅更新

订阅我的免费通讯,第一时间获取生成式 AI 领域优质内容

我承诺保护您的隐私,不会向第三方分享您的信息。

您可以随时取消订阅。

论文

- Meta 通过融合 Transformer 和 Diffusion 技术,开发了 Transfusion 模型,实现了文本和图像生成的大一统。Meta 最新发布的 Transfusion 模型,融合了 Transformer 和 Diffusion 技术,成功实现了文本和图像生成的统一。该模型在多模态序列上训练单个 Transformer,通过创新的方法显著提升了多模态处理的效率和质量。Transfusion 在单模态和多模态基准测试中表现卓越,生成的图像质量与扩散模型相媲美,并且保持了强大的文本生成能力。该模型展示了在多模态 AI 领域的巨大潜力,并预示了未来多模态技术的广泛应用。

- 大模型可控文本生成技术综述:全面概述用于控制大语言模型 中的文本生成的技术和方法。可控文本生成(CTG)的两个主要要求:满足预定义的控制条件,如主题一致性、安全性和风格一致性;以及保持文本质量,确保生成的文本流畅、有用且多样化。接着,论文从大语言模型的可控性维度和能力维度出发,定义了 CTG,并讨论了如何将控制条件集成到文本生成过程中。文章还将 CTG 任务分为内容控制和属性控制两大类,内容控制关注文本的具体元素,如结构和词汇;属性控制关注文本的抽象语言属性,如情感、风格和主题。论文进一步分类了 CTG 的方法,将其分为模型驱动方法和数据驱动方法,并讨论了 CTG 中条件的注入,包括训练阶段和推理阶段的方法。在训练阶段,方法包括重训练、微调和强化学习;在推理阶段,方法包括提示工程、潜在空间操作和解码时干预。

- 集成大语言模型与产业数据智能,迈向“产业基础模型”:随着数据量和模型规模的增加,大语言模型在指令执行、知识存储、逻辑推理和编程技能等方面展现出了突破性的能力。然而,大语言模型在产业领域的潜能尚未得到充分挖掘,特别是在满足产业数据分析、推理、预测、决策等数据智能需求方面。如何有效地变革各行业的数据模型及智能的构建方法与应用范式,仍然面临诸多挑战。为应对这些挑战,微软亚洲研究院提出了构建产业基础模型的倡议,其核心理念在于通过持续预训练,将产业数据智能相关的知识与技能融入到大语言模型中。基于这一理念,微软亚洲研究院开发了生成式表数据学习(Generative Tabular Learning,GTL)框架,展示了如何在表数据这一广泛使用的数据表征上,构建具有跨行业、跨数据模式、跨任务的产业基础模型。

- Meta Knowledge for Retrieval Augmented Large Language Models:Meta-Knowledge RAG 通过引入元知识(Meta-Knowledge)显著提升了 RAG系统 6 项关键性能指标。Meta-Knowledge RAG 模型,通过在传统 RAG 基础上融合元知识,不仅提高了检索效率,还增强了生成文本的相关性和准确性。该模型在多个基准测试中表现出色,对 6 项性能指标进行了显著提升,包括但不限于检索精确度、生成质量、多样性、一致性、可扩展性和鲁棒性。这些改进使得 Meta-Knowledge RAG 在处理复杂的自然语言处理任务时,尤其是在需要大量外部知识支持的场景下,展现了更高的效率和效果。

工程

Cursor 公布了他们的「Tab 补全」功能背后的技术细节 :文章首先指出现有的前沿模型如 GPT-4o 在进行大规模编辑时存在懒惰、不准确和高延迟的问题,尤其是在编码代理中,大规模编辑和小规模编辑都存在 bug 和效率低下的问题。Cursor 团队通过训练一个专门的模型来解决这个问题,该模型在全文代码编辑任务上的一个重要变体上表现出色,称为 “快速应用”(fast apply)。该模型将编码任务分解为规划和应用两个阶段,其中规划阶段通过聊天界面与强大的前沿模型交互,而应用阶段则采用了一种专门针对代码编辑的推理方法,称为 “推测性编辑”(speculative edits),能够实现每秒大约 1000 个 token(约 3500 个字符)的编辑速度。在评估 新模型时,文章还解释了为何重写整个文件而不是使用差异(diffs),以及推测性编辑如何带来巨大的速度提升。

通过构建一个由约 450 个全文编辑样本组成的评估集,文章使用 Claude-3 Opus 作为评分者来衡量几种模型的性能,并发现 Claude 模型的输出可能会偏向于更高的评分。文章还分析了不同模型在生成 diff 格式编辑时的表现,以及为何选择重写整个文件而不是生成差异。

70B大模型训练秘方① :数据集创建与评估:今年6月,大模型公司Imbue预训练了一个70B参数的模型,并在多选推理基准上进行了微调。在这些基准上,Imbue微调的模型超越了GPT-4o zero-shot表现(该模型未在这些基准上进行微调)。Imbue的微调模型,基于2万亿个Token进行预训练,其性能也接近于在超过7倍数据量上预训练的Llama3 70B微调模型的性能。由于他们在没有使用思维链的情况下评估了GPT-4o zero-shot的性能,因此上文指出的性能表现并不代表它在这些数据集上能达到的最佳成绩。然而,这是与微调后的70B模型评估最直接的对比,这些评估同样不包括思维链。通过使用他们提出的超参数优化器CARBS,他们在首次尝试时将该系统规模扩展到70B参数,同时保持训练过程中的最小不稳定性,并未出现损失激增的情况。这涉及到训练数千个密集型Transformer模型,具有分组查询注意力、SwiGLU激活、RMS归一化和自定义词元分词器,并在一系列较小规模的范围内训练。本文中,他们要分享的是用于模型评估的数据集,包含11个公共数据集的高质量子集,以及一套用于代码理解的原始问题。

ggml 简介:ggml是一个用 C 和 C++ 编写、专注于 Transformer 架构模型推理的机器学习库。该项目完全开源,处于活跃的开发阶段,开发社区也在不断壮大。ggml 和 PyTorch、TensorFlow 等机器学习库比较相似,但由于目前处于开发的早期阶段,一些底层设计仍在不断改进中。相比于llama.cpp和whisper.cpp等项目,ggml 也在一直不断广泛普及。为了实现端侧大语言模型推理,包括ollama、jan、LM Studio等很多项目内部都使用了 ggml。

GPUd:GPUd 是一个为 AI 设计的 GPU 管理工具,它能显著降低 GPU 集群的不可用性,提高硬件资源的有效利用。这个工具由 Lepton AI 的专家团队开发,他们在 Meta、阿里巴巴和 Uber 等公司积累了丰富的经验。GPUd 能够自动化监控、诊断和问题识别,适用于云环境或本地部署,无论集群规模如何。通过采用 GPUd,Lepton AI 观察到人工干预减少了 80%,GPU 不可用性降低了 50%。GPUd 提供了全面的系统和硬件监控,支持对 ECC 错误、NVLink/NVSwitch 错误、PCIe 问题和电源供应问题等多种 GPU 状态进行检测。此外,GPUd 还能够监控 GPU (InfiniBand/RoCE)状态并报告任何故障,并在可能的情况下执行自动修复和诊断。用户可以通过一个命令轻松收集系统统计信息和日志进行进一步分析。

ComfyUI-Yolain-Workflows,最近在搞非语言模型相关的产品,需要用到ComfyUI,看到一份较全面的 ComfyUI 工作流合集,从基础到进阶再到落地应用,涵盖了图生图、细节修复、背景去除、重绘/扩图、人脸迁移、重绘光影、电商产品主图等工作流,很有用,希望帮到需要用到的朋友。

产品

AI21 Labs 发布了基于 Mamba 架构的 Jamba 1.5 系列模型:AI21 Labs 发布了基于 Mamba 架构的 Jamba 1.5 系列模型,该模型在长上下文处理能力、速度和质量上超越了同尺寸级别的竞争对手,标志着非 Transformer 模型首次在市场上取得领先地位。Mamba 架构由卡内基梅隆大学和普林斯顿大学的研究人员提出,旨在解决传统 Transformer 架构在内存占用和推理速度上的限制。Jamba 1.5 系列通过结合 Transformer 和 Mamba 的优势,实现了在长上下文处理、速度和质量上的显著提升,支持多语言,并提供了市场上最长的 256K 有效上下文窗口。此外,Jamba 1.5 系列在各种基准测试中表现优异,尤其是在 Arena Hard 基准测试中超过了同类模型。

AI21 Labs 由AI领域的先驱人物 Amnon Shashua 教授(Mobileye 创始人兼 CEO)、Yoav Shoham 教授(斯坦福大学名誉教授,曾任谷歌首席科学家)及 Ori Goshen(CrowdX 创始人)于 2017 年共同成立,旨在打造能够与人类思维并行的AI系统。

2023 年 8 月,AI21 Labs 宣布完成了 1.55 亿美元的 C 轮融资,该轮融资由 Walden Catalyst、Pitango、SCB10X、b2venture、Samsung Next 以及 Amnon Shashua 教授领投,Google 和 NVIDIA 也参与了投资,此次融资将公司的总融资额提升至 2.83 亿美元,公司估值达到 14 亿美元。

2023 年 11 月 22 日,AI21 Labs 进一步宣布,C 轮融资的超额认购额达到 2.08 亿美元,使总融资额上升至 3.36 (2.08-1.55+2.83)亿美元。此轮投资的参与者包括英特尔资本、康卡斯特风险投资公司和 Ahren Innovation Capital 等。

通过投资者的构成,AI21 Labs 显示出对产业资本的吸引力。这与公司的市场定位相符,即为特定企业客户定制模型,协助企业打造自家的生成式 AI 应用。

AI21 Labs 的联合首席执行官兼联合创始人 Ori Goshen 强调:“一刀切的解决方案并非适合所有企业,因为它们需要能够理解其独特需求的合作伙伴。大规模部署AI需要高性能的语言模型,这些模型能够深入理解并提供更大的价值和影响力。我们的方法是专门设计AI解决方案,以实现更高的效率和成本效益,而非从零开始构建。”

Twelve Labs: 多模态重塑视频内容检索:Twelve Labs 成立于 2020 年,通过 API 为企业和开发者提供视频领域的多模态视频基础模型,主要用于视频多模态检索,用户可以通过输入文字、图片来寻找视频中的任意内容。公司的愿景是成为视频领域的 ChatGPT,目前在视频多模态搜索领域处于领先地位,其产品的搜索结果准确、速度快、泛用性好、产品运营能力强。Twelve Labs 的视频理解模型可以实现对视频的多模态搜索,客户普遍评价其搜索质量很好。公司自 2020 年成立以来融资超过 7,700 万美元,拥有多位知名投资者,包括 Nvidia、Intel Capital 等。

智谱AI技术团队开源CogVideoX-5B ,同时 CogVideoX-2B 的开源协议调整为更加开放的Apache 2.0协议:8 月 6 日,智谱 AI 技术团队发布并开源了 CogVideoX-2B 模型,并在 8 月 6 日后对其进行了优化,包括支持多种推理精度(FP16、BF16、FP32、INT8),以及在不同精度下的推理性能优化。例如,在 INT8 精度下,推理显存需求为 7.8GB,即使用 1080 Ti 显卡也能完成推理;在 FP16/BF16 精度下,单卡 A100 和 H100 的推理时间分别为 90 秒和 45 秒。此外,LoRA 和 SFT 微调的显存需求分别为 47GB 和 62GB。随后,团队决定将参数规模更大、性能更强的 CogVideoX-5B 模型开源,该模型支持多种推理精度,推理显存需求最低为 11.4GB,LoRA 和 SFT 微调的显存需求分别为 63GB 和 75GB。为了支持开源社区,CogVideoX-2B 的协议被调整为 Apache 2.0 协议,任何企业或个人可以自由使用。

代码仓库:https://github.com/THUDM/CogVideo

模型论文:https://arxiv.org/abs/2408.06072

模型下载:

- Huggingface:https://huggingface.co/THUDM/CogVideoX-5b

- 魔搭社区:https://modelscope.cn/models/ZhipuAI/CogVideoX-5b

在线体验:

Anthropic 公布了Claude 系统提示:Anthropic 近期公布了Claude 系统提示。这些提示旨在帮助用户更好地理解 AI 的工作原理,提高交互的透明度和效率。系统提示包括了一系列的指令和信息,用于引导用户如何与 Claude 进行有效的对话。例如,用户可以通过提示来指导 Claude 解决特定问题,或者要求 AI 解释其回答的来源和逻辑。此外,Anthropic 还强调了 AI 安全性的重要性,并介绍了他们在这一领域的一些努力。他们提到,通过这些系统提示,用户可以更容易地识别和纠正 AI 可能出现的偏差或错误,从而提升整体的用户体验。

程序员的 AI 神器:Cursor:AI 辅助编程产品Cursor最近很出圈,这篇文章对它的功能进行介绍。Cursor 的功能非常丰富强大,每一个功能点背后都包含着对于 workflow 的深入理解和 UX 的精心设计。作者通过在自己的一些真实项目中进行了尝试,这些功能的完成度也非常不错,完全不是那种只能从头生成个简单脚本的 demo 产品,也难怪 Cursor 受到了很多开发者的欢迎。Cursor支持自定义接入大模型API,自定义提示词,这个项目收集了一些优质提示词。

Napkin AI:Napkin AI 是专门针对文本到视觉内容转换的工具。用户只需输入或粘贴文本,Napkin AI 便能自动生成相应的视觉效果,包括但不限于图表、信息图、流程图等。使用此工具不需要额外的提示或复杂操作,它提供了多种可编辑选项,让用户可以根据自己的需求调整视觉效果。此外,Napkin AI 支持多种格式的导出,如 PNG、PDF 或 SVG,这使得生成的视觉效果能够方便地应用于演示文稿、文档、社交媒体等场景。

Qwen2-VL: 更清晰地看世界:通义千问团队推出的最新一代视觉语言模型Qwen2-VL ,它在视觉理解、长视频处理、智能设备操作、多语言支持等方面都有显著提升。该模型基于 Qwen2 构建,在 MathVista、DocVQA、RealWorldQA、MTVQA 等视觉理解基准测试中展现了全球领先的表现。Qwen2-VL 能够理解超过 20 分钟的长视频,并将其应用于问答、对话和内容创作等场景。同时,该模型还能够集成到手机和机器人等设备中,根据视觉环境和文字指令进行自动操作。在多语言支持方面,Qwen2-VL 支持英语、中文以及多种欧洲语言、日语、韩语、阿拉伯语、越南语等。Qwen2-VL 的 2B 和 7B 版本已在 Apache 2.0 协议下开源,并提供了 72B 版本的 API。开源代码已集成到 Hugging Face Transformers、vLLM 和其他第三方框架中。该模型从六个方面评估视觉能力,包括大学题目、数学能力、文档表格多语言文字图像的理解、通用场景下的问答、视频理解、Agent 能力,并在大部分指标上达到了最优,甚至超过了 GPT-4o 和 Claude3.5-Sonnet 等闭源模型。

Qwen2-VL 展现了更细节的识别理解能力,能够识别植物和地标,理解场景中多个对象间的关系,并增强了对手写文字及图像中多种语言的识别能力。在视觉推理方面,Qwen2-VL 的数学和编程能力得到了增强,能够通过分析图片解决问题,并从真实世界图像和图表中提取信息。此外,该模型还能够总结视频要点、即时回答相关问题,并维持连贯对话。在 Visual Agent 能力方面,Qwen2-VL 支持函数调用和视觉交互,能够利用视觉能力完成一些自动化的工具调用和交互。Qwen2-VL 在架构上支持原生动态分辨率和多模态旋转位置嵌入(M-ROPE),以更好地捕捉和整合一维文本序列、二维视觉图像以及三维视频的位置信息。用户可以通过官方 API 体验最强模型 Qwen2-VL-72B,并且可以在 Hugging Face 和 ModelScope 上找到 2B 和 7B 模型的开源代码。LeptonAI 还提供了工具和指南帮助开发者处理不同类型的视觉输入,并支持多个三方框架。

智谱发布新一代基座模型:这些模型包括语言模型 GLM-4-Plus、文生图模型 CogView-3-Plus、图像 / 视频理解模型 GLM-4V-Plus、视频生成模型 CogVideoX 等。此外,智谱还在「清言 APP」上线了视频通话功能,并在 MaaS 平台上开放了 GLM-4-Flash API 的免费使用。GLM-4-Plus 模型在语言理解、指令遵循、长文本处理等方面性能得到全面提升,保持了国际领先水平。CogView-3-Plus 模型具备与当前最优的 MJ-V6 和 FLUX 等模型接近的性能。GLM-4V-Plus 模型具备卓越的图像理解能力,并具备基于时间感知的视频理解能力,成为国内首个通用视频理解模型 API。CogVideoX 模型在发布并开源 2B 版本后,5B 版本也正式开源,其性能进一步增强。「清言 APP」上线的视频通话功能是国内首个面向 C 端用户开放的服务,具备实时推理能力。GLM-4-Flash API 提供了完全免费的推理服务,并提供了微调服务。

市场

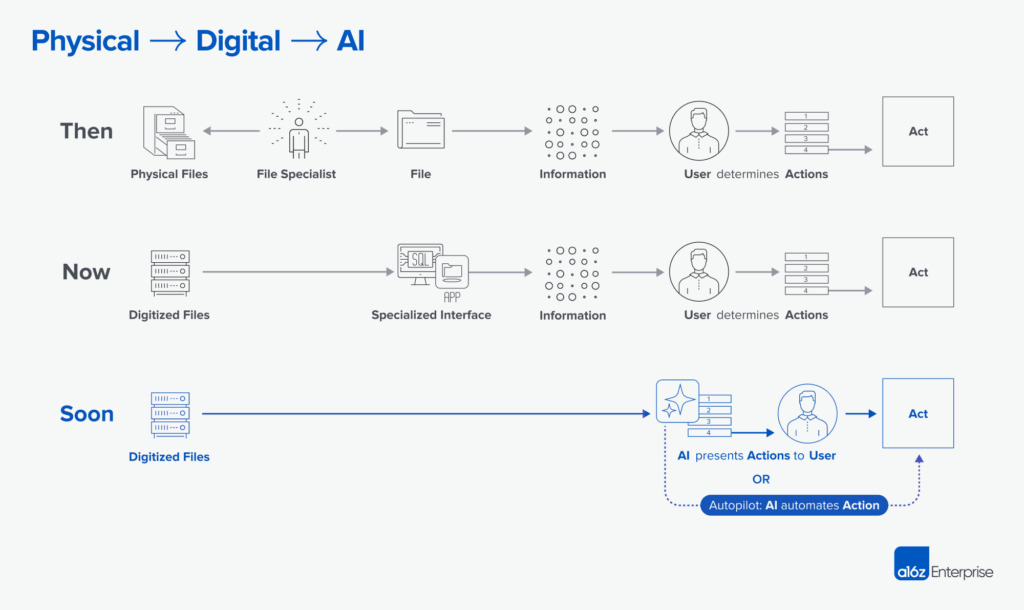

AI应用正在这4个大场景里加速落地:企业对于 GenAI 的重视度在增加,但部署速度受限于模型能力、成本和现有工作流耦合成本等因素。预计到 2025 年,GenAI 将进入大规模采用阶段。企业对于如何有效利用 AI 工具的理解不足,以及市场供给不足,成为了新的阻碍。在企业侧,GenAI 的渗透速度比预期更快,特别是在提升内部生产力和优化劳动力成本方面。到 2024 年末,预计更多中大型企业将扩展 GenAI 的部署规模,并将其应用到更广泛的业务流程中。企业对于 AI 的预期和模型能力之间存在不匹配,这在于模型的 “渐进式解锁” 特点和企业对 AI 的理解不足。中短期内,企业的 GenAI 用例主要集中在内部场景,如企业搜索、AI 客服、销售与市场、产品开发等。企业搜索和 AI 客服尤其是渗透速度最快的场景。在产品开发中,代码生成和内容生成都得到了 AI 的加速。此外,LLM 在垂直场景如电商、法律和金融服务等领域也展现出成本降低的效果。

企业在部署 AI 时,面临数据完备度(data readiness)的挑战,这影响了 AI 用例的部署速度和实施效果。目前,只有约 35% 的公司能清晰描述如何从 GenAI 中创造商业价值,这个转变可能需要 3-5 年的时间。

红杉资本对话GitHub CEO:在与红杉资本的对话中,GitHub CEO 托马斯・多姆克(Thomas Dohmke)详细阐述了 GitHub Copilot 的自动补全功能如何成为该产品成功的核心。他指出,Copilot 能够在编辑器中自动补全代码,不仅限于单行代码,还能够扩展到多行代码,这使得开发者能够在不改变原有工作习惯的情况下,获得灵感并大幅提升编程效率。此外,多姆克透露了 Copilot 的一个意外之处:它能够生成超出预期的代码量,达到 25%,这不仅仅基于文件中已有的内容,还能够识别相邻的标签,并根据上下文提供更加针对性的建议,从而成为了减少开发者重复劳动的强大工具。

观点

面向LLM应用的中间层平台产品:本文是针对中间层平台产品的深入讨论,特别是在大语言模型应用领域。作者首先阐述了平台产品与厂家专卖店的区别,强调平台应该以满足用户需求为中心,而非仅仅提供自身技术能力。文章分为三个阶段来探讨平台的目标与价值:第一阶段聚焦于降低开发者成本、补全能力环节和分摊成本;第二阶段关注于降低不同开发者之间协作成本,并提供一个各方可以相互发现的平台;第三阶段则是向开发者提供商机与收入。在第一阶段,作者讨论了平台应该如何赋能能力不完备的开发者和小规模开发团队,以及如何降低开发成本和提升开发效率。第二阶段则强调了平台作为集市的作用,降低交易成本,以及如何降低组合原子能力的成本。最后,作者提到了人工服务也可以作为产品提供,并以此结束对中间层平台产品的探讨。

新一代皮克斯即将诞生,还会「干掉」电影和游戏:a16z最新文章,技术的进步将带来内容生产和消费方式的变革,以 Sora 为代表的视频生成技术可能会改变未来的影视与游戏内容生产流程,作者认为,互动视频领域将诞生新一代的皮克斯,甚至新一代的 TikTok,历史上,技术的每一次浪潮都伴随着新的创作方式的出现,今天,GenAI 正在推动创意故事叙述的根本性转变。文章讨论了游戏如何成为新叙事方式的引领者,消费者转向交互式媒体,以及生成式人工智能推动的技术进步,都可能会加速新一代故事创作公司的诞生,对于 Z 世代及更年轻的一代来说,游戏已成为消磨时间的首选方式。互动媒体之所以有影响力,是因为它能够培养对故事或世界的亲近感。互动视频是故事与游戏的完美融合,能够提供个性化、无限的游戏玩法,尽管过去的互动剧因人工制作成本太高而失败,但 AI 制作短片的成本仅为租用镜头一天的费用。

文章分析了互动视频行业的现状,并估计可能还需要约 2 年的时间才能实现商业上可行的、完全生成的交互式视频。微软、OpenAI 等机构正在努力为交互式视频构建端到端的基础模型。在应用层,一些团队正在探索新形式的交互式视频体验。新一代的皮克斯需要既懂技术又懂内容,皮克斯的成功不仅仅是技术创新,还需要一支能够与 AI 工具协同工作的创意团队,未来的皮克斯将是一个能够创造新的故事世界,模糊传统叙事格式界限的顶尖技术公司。

生成式AI的终局

生成式AI的终极应用,我始终认为,在B端,它将打通企业自动化的“最后一公里”,实现全过程自动化,即软件转化为劳动力,成为真正的数字员工。a16z最近发表的一篇文章《AI Turns Capital to Labor》也探讨了这一观点。

在C端,生成式AI的无限内容生成能力将为每个人构建一个独特的数字世界,打造个人专属的“元宇宙”。我曾在去年4月阅读过一篇非常有洞察力的文章(《Midjourney 正在崛起,有望成为下一个 Netflix(甚至挑战 YouTube)》),它预见了这一趋势,如今MidJourney宣布进军智能硬件领域,正是这一趋势的体现。

由于还没有所谓killer app出现,我相信过不了多久,一些互联网投资人和评论家可能会怀疑这一波生成式AI是否只是泡沫。这也符合Gartern技术成熟度曲线,但是生成式AI应用已经大面积渗透进企业了,这其中产生的价值不输一个C端的killer app。那些只懂空谈理论而没有亲身参与实践的人,自然难以察觉到这一点。说回C端,为什么没有killer app,而且我认为最近两三年也不会有,算力(成本)限制是一方面,另一方面是没有成熟的硬件形态来承载。

回顾上一次深度学习技术带来的商业价值,它通过搜索、推荐、广告等方式提高了我们获取信息的效率,并持续塑造新的信息消费模式,为许多互联网公司奠定了商业基础。那么,这项技术是如何与C端用户连接的呢?最典型的就是抖音的上下滑。对于生成式AI技术,尽管短期内许多手机厂商都在集成AI,但这仅仅是一个过渡状态,我们需要新的硬件形态来实现更好的连接性和交互性,我能想到的是类似 joy con手柄捕捉动作,当然最热的还是下面这些方向。

- 增强现实眼镜/隐形眼镜

- 集成AI处理器,实时生成和叠加视觉信息

- 通过眼动追踪技术实现无声交互

- 实时翻译、环境信息增强、个性化视觉体验

- 神经接口设备

- 直接与大脑进行信息交换的轻量级可穿戴设备

- 思维控制AI、直接输入/输出信息、增强认知能力

- 智能皮肤贴片

- 超薄、柔性的贴在皮肤上的AI处理器

- 通过触觉反馈和生物电信号采集实现人机交互

- 健康监测、情绪识别、触觉增强现实

- 智能织物

- 集成AI芯片和各种传感器的智能服装

- 通过服装实现全身范围的人机交互

- 全天候健康监测、环境适应、情绪调节

Vol.19:AI应用正在这4个大场景里加速落地