Vol.21:OpenAI o1合成数据与推理搜索

⼤家好,Weekly Gradient 第 21 期内容已送达!

✉️ 免费订阅更新

订阅我的免费通讯,第一时间获取生成式 AI 领域优质内容

我承诺保护您的隐私,不会向第三方分享您的信息。

您可以随时取消订阅。

论文

RetrievalAttention:通过向量检索加速长上下文 LLM 推理:长上下文 LLM 在大数据处理方面表现出色,但推理效率受限于注意力机制的二次时间复杂度。现有的 KV 缓存技术虽然可以避免重复计算,但在长上下文场景下仍存在 GPU 内存需求大和推理延迟高的问题。为了解决这些问题,该研究提出了 RetrievalAttention 方法,核心创新包括:将大部分 KV 向量卸载到 CPU 内存,构建近似最近邻搜索 (ANNS) 索引;提出注意力感知的向量搜索算法,以解决查询向量和键向量之间的分布差异问题;采用 CPU-GPU 协同执行策略,在 GPU 上保留可预测的重要 KV 向量,动态检索 CPU 上的相关向量。实验结果显示,RetrievalAttention 在多个长上下文基准测试上与全注意力相比保持了相近的准确性,并在 128K 上下文长度的场景下实现了显著的解码延迟减少。此外,该方法仅需 16GB GPU 内存即可在单个 NVIDIA RTX4090 上处理 8B 参数模型的 128K tokens,每 token 生成时间为 0.188 秒。

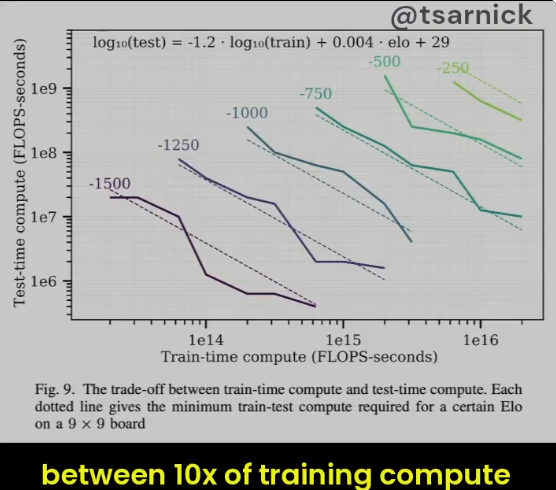

Large Language Monkeys: 通过重复采样扩展推理计算:OpenAI o1模型的创新之一,详细探讨了在推理过程中,通过扩展计算量(即增加推理时的计算资源)来提升大语言模型解决复杂任务的能力。论文的核心思想是,通过生成多个不同的解决方案(也就是“重复采样”),而非依赖单次尝试来解决问题,能够显著提高解决问题的成功率,尤其在代码生成、数学推理等可以通过自动验证器验证的任务中。

通用 OCR 理论:通过统一的端到端模型实现 OCR-2.0:由阶跃星辰团队开源的 OCR-2.0 模型 GOT,该模型在不到一周的时间内登上了 Hugging Face 趋势榜单,展现了强大的多模态大模型能力,并且在多种场景下都有显著的应用潜力,包括 PDF image 转 Markdown、双栏文本感知、自然场景和细粒度 OCR、动态分辨率 OCR、多页 OCR 以及更多符号的 OCR 能力。尽管 GOT 表现出色,但研究团队也指出了其局限性,如更多语言的支持、更复杂的几何图和 chart 上的 OCR 性能等。研究团队认为 OCR-2.0 的研究还远远没有结束,GOT 模型也有很大的提升空间。论文还详细介绍了 GOT 模型的结构和训练方法,包括采用的 vision encoder、input embedding layer 和 decoder 的 pipeline,以及 Encoder 使用的 VITDet 架构和双卷积设计方案。训练过程分为三个阶段:高效预训练 encoder、联合训练 encoder-decoder、以及锁住 encoder 加强 decoder。研究团队为了构造各种数据,学习了多种数据渲染工具,如 LaTex、Mathpix-markdown-it 等,强调了数据工程在 OCR 模型训练中的重要性,并通过多种数据渲染工具来构造数据集。

论文地址:

https://arxiv.org/pdf/2409.01704项目地址:

https://github.com/Ucas-HaoranWei/GOT-OCR2.0Hugging Face 地址:

https://hf.co/ucaslcl/GOT-OCR2_0Understanding LLMs: A Comprehensive Overview from Training to Inference:这篇论文试图提供一个全面的概述,从训练到推理,关于大语言模型的发展。它讨论了LLMs在自然语言处理(NLP)中的应用,特别是在处理下游任务时的高效训练和部署。涉及了数据预处理、训练架构、预训练任务、并行训练以及与模型微调相关的相关内容。在推理方面,论文涵盖了模型压缩、并行计算、内存调度和结构优化等主题,此外,它还探讨了LLMs的利用方式,并提供了对其未来发展的见解。

工程

OpenAI o1: 合成数据与推理搜索:文章首先介绍了合成数据的概念,即通过算法生成的数据,用于模拟真实世界的情况,以便于机器学习模型的训练和测试。接着,详细阐述了推理搜索的过程,即在给定的数据和条件下,通过逻辑推理和搜索算法找到最佳解决方案的技术。文章强调了合成数据在提高模型泛化能力和推理搜索在解决实际问题中的重要性。最后,文章提到了 OpenAI o1 在这些领域的研究成果和未来的发展方向。

Awesome-LLM-Strawberry:这是一个关于 OpenAI Strawberry(o1) 和逻辑推理的研究论文与博客的合集,以追踪大模型逻辑推理领域的前沿进展。

Anthropic 推出了上下文检索(Contextual Retrieval)方法:Anthropic 发布了一篇关于上下文检索(Contextual Retrieval)的文章,这种方法能够显著提高基于知识库的信息检索的准确性。传统的基于知识库的生成(Retrieval-Augmented Generation, RAG)方法通过将相关信息附加到用户的提示中来增强模型的响应,但它在编码信息时往往会丢失上下文,导致检索不相关的信息。上下文检索通过在每个文本块前添加解释性的上下文,既可以在嵌入模型中使用(上下文嵌入),也可以在 BM25 索引中使用(上下文 BM25),从而提高了检索的准确性。实验结果显示,上下文嵌入和上下文 BM25 的结合可以减少 49% 的检索失败率,结合重新排名(Reranking)技术后,失败率可以进一步降低 67%。此外,Anthropic 还提供了使用 Claude 模型进行上下文检索的实现指南和成本优化策略。

Noam Brown 是领导 OpenAI 多 Agent、多步骤推理、强化学习等方面的核心人物,最近随着 O1 发布, Noam Brown 逐渐走向台前,这是之前在华盛顿大学的讲座分享。

Zep:Zep 的工作原理是通过持久化聊天历史记录,并从中自动生成摘要和其他衍生物,如消息和摘要的嵌入,这使得用户能够从过去的对话中检索相关的上下文信息。这些操作是异步执行的,以避免对用户聊天体验造成影响。数据被持久化到数据库中,这允许系统在需要时进行扩展。此外,Zep 提供了一个名为 Document Collections 的文档向量搜索的简单抽象,它旨在补充 Zep 的核心记忆功能,但并不打算成为一个通用的向量数据库。Zep 还允许用户更有意识地构建提示,包括自动添加几条最近的消息(数量可以根据应用定制)、在这些消息之前的最近对话的摘要,以及整个聊天会话中上下文相关的摘要或消息,还可以包括来自 Zep Document Collections 的相关业务数据。

产品

Qwen2.5系列模型开源:Qwen2.5 系列包括了语言模型 Qwen2.5、专为编程优化的 Qwen2.5-Coder 和专注于数学的 Qwen2.5-Math。这些模型有多种不同规模的版本,包括从 0.5B 到 72B 的参数量。除了 3B 和 72B 版本采用特定许可证,其他模型均采用 Apache 2.0 许可证。此外,Qwen 团队还提供了 Qwen-Plus 和 Qwen-Turbo 等旗舰语言模型的 API 服务。相较于 Qwen2,Qwen2.5 获得了显著更多的知识(MMLU:85+),并在编程能力(HumanEval 85+)和数学能力(MATH 80+)方面有了大幅提升。此外,新模型在指令执行、生成长文本(超过 8K 标记)、理解结构化数据(例如表格)以及生成结构化输出特别是 JSON 方面取得了显著改进。 Qwen2.5 模型总体上对各种system prompt更具适应性,增强了角色扮演实现和聊天机器人的条件设置功能。与 Qwen2 类似,Qwen2.5 语言模型支持高达 128K tokens,并能生成最多 8K tokens的内容。Qwen2.5 支持多达 29 种语言,并且提供了与前代模型兼容的系统提示。于编程的 Qwen2.5-Coder 和用于数学的 Qwen2.5-Math,相比其前身 CodeQwen1.5 和 Qwen2-Math 有了实质性的改进。 Qwen2.5-Coder 在包含 5.5 T tokens 编程相关数据上进行了训练,使即使较小的编程专用模型也能在编程评估基准测试中表现出媲美大型语言模型的竞争力。 同时,Qwen2.5-Math 支持 中文 和 英文,并整合了多种推理方法,包括CoT(Chain of Thought)、PoT(Program of Thought)和 TIR(Tool-Integrated Reasoning)。

Jina AI 推出Reader-LM: 将原始 HTML 转换为干净 Markdown 的小语言模型:Jina AI 在 2024 年 4 月发布了 Jina Reader,这是一个可以将任何 URL 转换成 LLM(大型语言模型)友好的 Markdown 格式的简单 API。尽管背后有复杂的网络编程,但核心的 “阅读” 部分相对简单,通过使用无头 Chrome 浏览器获取网页源代码,利用 Mozilla 的 Readability 包提取主要内容,并使用 regex 和 Turndown 库将清理后的 HTML 转换成 Markdown。在发布后,公司收到了用户反馈,指出内容质量存在问题,如过于详细或不够详细,以及过滤器错误移除内容或 Turndown 转换 HTML 时的困难。为解决这些问题,公司采取了修补现有管道的措施。随后,Jina AI 探索了是否可以用语言模型来解决这个问题,而不是继续使用更多的启发式方法和 regex。他们发现,对于 HTML 到 Markdown 的转换任务,小型语言模型(SLM)可能是一个解决方案,因为这项任务主要是选择性复制输入到输出,而不需要创造性地生成新内容。因此,他们开发了 Reader-LM-0.5B 和 Reader-LM-1.5B 两款 SLM,这两款模型专门用于生成干净的 Markdown 格式,并且在多语言和长上下文支持方面表现出色。这些模型在性能上超过了更大的 LLM,同时模型大小只有后者的 1/50。Jina AI 还提供了模型规格、如何在 Google Colab 上开始使用、在生产环境中的可用性以及如何训练 Reader-LM 的详细信息。最后,他们通过定量和定性研究对 Reader-LM 进行了评估,证明了其在转换和清理 HTML 到 Markdown 方面的优势。

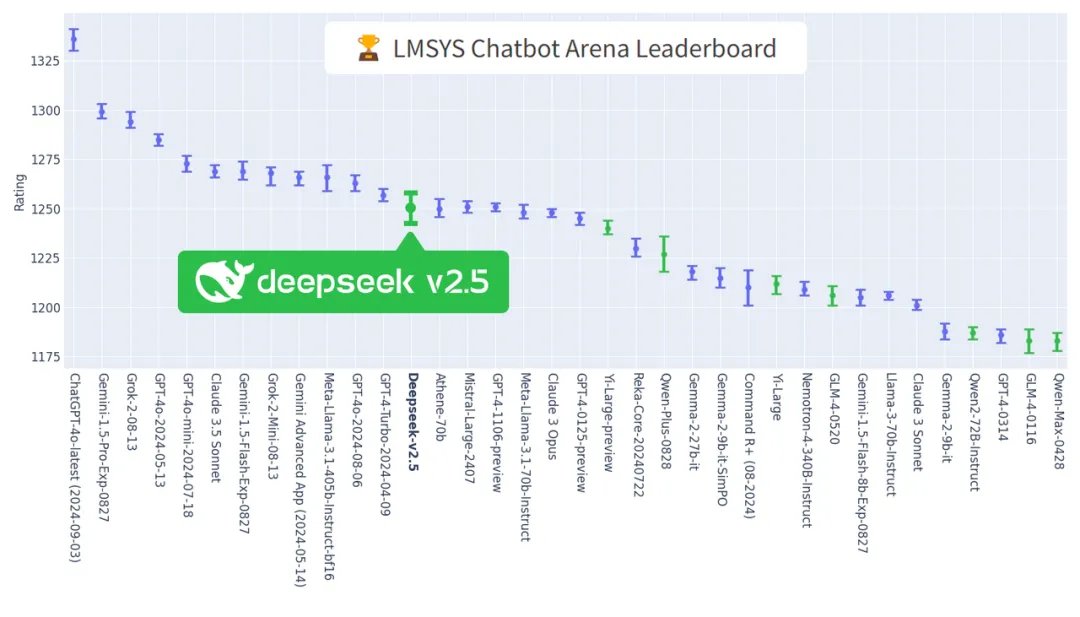

DeepSeek-V2.5全面领跑国内模型:LMSYS 组织的全球大模型竞技场(ChatBotArena)更新结果发布,DeepSeek-V2.5 排名位列国内大模型第一,开源超越国内最强闭源模型(Yi-Large-Preview, Qwen-Plus-0828, GLM-4-0520),并在8个单项能力上均领跑国内模型。

Napkin:Napkin AI 是一个直接从文本生成视觉内容的平台,它可以快速有效地帮助用户分享和传达想法。使用 Napkin AI 的过程包括粘贴文本、生成相关视觉内容、编辑和个性化设计元素(如图标、装饰元素、连接线、颜色和字体),以及将最终的视觉内容导出为 PNG、PDF 或 SVG 格式,以便在不同的场景中使用,如演示文稿、博客、社交媒体和文档。Napkin AI 的使用案例包括增强演示文稿的影响力、为博客留下深刻印象、在社交媒体上吸引观众、编写易于阅读的文档,以及通过视觉故事讲述捕捉观众的注意力。

市场

- 中国政务行业大模型发展洞察:一些关于国内toG市场的竞争现状。

- 2024年中国金融大模型产业发展洞察报告

- 2024年AI应用市场洞察:报告提供2024年关于App Store和Google Play渠道AI应⽤市场的深度分析,其中包括2024年AI应⽤下载量与收⼊趋势,不同市场下载量与收⼊分布,头部AI应⽤下载量排⾏,以及AI+Chatbot与AI+图像视频两个主要细分市场头部应⽤表现,Sensor Tower出品。

观点

OpenAI o1 来了!与硅流袁进辉聊 o1 新范式和开发者生态:讨论了 OpenAI 新模型 o1 的发布,并邀请了硅基流动创始人袁进辉探讨了 o1 模型的新范式、对开发者生态的影响,以及 AI 开发者社区一年来的变化。o1 模型通过强化学习、思维链和测试时间计算(test-time compute)显著提升了逻辑推理能力,特别在科学、数学和编程等领域表现出色。袁进辉在节目中详细解释了这些概念,并讨论了它们对算力消耗和行业应用的影响。他指出,尽管 GPU 算力总消耗会提升,但目前存在冗余,且 AI 应用开发的热情并未冷却,只是不再是风险投资者关注的焦点。袁进辉还分享了一些一手数据,如硅基流动客户调用最多的开源模型,并探讨了 o1 模型对中国的影响,以及算力需求和价格变化的趋势。此外,他还提到了 AI 应用开发的分散化、个人化趋势。

杨植麟、姜大昕、朱军探讨大模型技术路径:在 2024 云栖大会上,阶跃星辰创始人姜大昕、月之暗面Kimi创始人杨植麟、生数科技首席科学家朱军探讨了各自眼中 AI 技术发展的现状,推演未来 18 个月,大模型行业会发生什么。

- AI 技术在过去的 18 个月里加速了发展,不仅数量上有很多新模型、产品和应用涌现,而且在质量上也取得了突破,尤其是在多模融合、推理能力和应用层创业方面。

- OpenAI o1 模型的发布提升了 AI 的上限,它的推理能力更强,能够进行系统 2 的慢思考,这对于 AGI 的发展是一个重要的进步。

- o1 模型的出现代表了一个新的技术范式,它不仅提升了 AI 的能力上限,还带来了一个新的 Scaling Law 技术范式,即 RL Scaling。

- 尽管 AI 技术的发展进程在加速,但推理能力泛化的路径还不明确,需要解决过程监督的数据、Reward Model 的定义等问题。

- 新范式对算力的需求会更大,特别是在推理侧和训练侧,RL 方法可能会导致算力需求的增长。

- AI 应用层的创业需要在延时增加带来的用户体验下降和结果质量上升之间找到平衡点,以及产品形态上的变化,以适应 AI 的新能力。推理能力将向物理世界落地,AI 技术的发展将更多地与机器人、自动驾驶等具身智能方面结合,提升生产力和创新能力。

- 对于 AI 创业公司来说,技术进步为创新提供了更大的空间,但同时也提出了更高的对算力和数据的需求。在选择 AI 创业项目时,投资者会关注产品的 PMF(Product-Market Fit)、增量价值、市场规模的潜力等因素。

- 在未来 18 个月里,期待看到 L3 级别的 AGI,即智能体能够在物理世界中做出决策和交互,甚至可能在 L4 级别的科学发现和创新方面取得进展。期待在视觉领域的理解和生成一体化方面取得进展,这将有助于建立一个多模的世界模型。(注:AGI 大概做过一些分级,学术界和产业界有 L1-L5 的分级,L1 相当于聊天机器人,像 ChatGPT 等,之前大家做了很多对话。L2 叫推理者,可以做复杂问题深度思考的推理。L3 叫智能体,「数字世界」走向「物理世界」,要去改变,去交互。L4 是创新者,要去发现、创造一些新的东西,或者发现一些新的知识。L5 是组织者,它可以去协同,或者有某种组织方式更高效地运转,这是大家对于 AGI L1-L5 的分级,当然每一级也有 narrow 和 general 的区分,现在在某些任务上可以展示出来。)

Vol.21:OpenAI o1合成数据与推理搜索