Vol.22:垂直 SaaS 如何通过 AI 来提高收入?

大家好,预祝大家国庆快乐,玩得开心!Weekly Gradient 第 22 期内容已送达!

✉️ 免费订阅更新

订阅我的免费通讯,第一时间获取生成式 AI 领域优质内容

我承诺保护您的隐私,不会向第三方分享您的信息。

您可以随时取消订阅。

论文

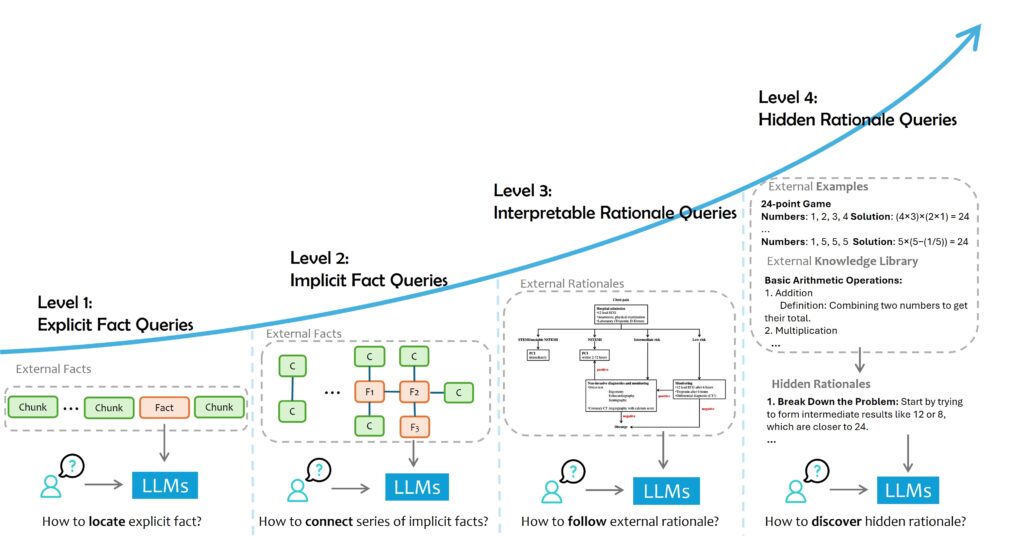

RAG and Beyond:关于如何让 LLMs 更明智地使用外部数据的全面调查:微软亚洲研究院(MSRA)针对将外部数据整合到大语言模型的技术,提出了一种任务分类方法,将用户查询分为四个层次:显式事实查询(L1)、隐式事实查询(L2)、可解释推理查询(L3)和隐式推理查询(L4)。这四个层次从直接从数据中检索事实到需要推理出隐含的推理逻辑,逐渐增加了查询的复杂性。为了有效地整合外部数据,微软提出了三种方法:将领域数据作为 LLM 的上下文输入、训练一个小型模型以指导 LLM 整合外部信息、以及直接对 LLM 进行微调,使其成为领域专家模型。每个层次的查询都面临不同的挑战,例如数据处理、检索和评估的困难,以及解决方案,如数据预处理增强、数据检索增强和检索增强生成(RAG)等。在处理隐式事实查询(L2)时,需要考虑自适应检索量和推理与检索的协调。而对于可解释推理查询(L3)和隐式推理查询(L4),则涉及到如何优化提示(Prompt)、提高可解释性、进行逻辑检索和解决数据不足等问题。微软还提出了一系列解决方案,如迭代 RAG、基于规划的检索、信息差填补、图 / 树问题回答、NL2SQL、Prompt Tuning、CoT Prompting、离线学习、上下文学习(ICL)和微调等,以提高 LLM 在处理复杂查询时的性能和效率。

Moshi:用于实时对话的语音-文本基础模型:对标 OpenAI 高级语音的 Moshi 全面开源,包括论文、技术细节、权重和代码。Moshi 由三个主要组件构成:Helium(基于 2.1T 标记训练的 7B 语言模型)、Mimi(一种神经音频编解码器)以及新的多流架构。Moshi 能够实现实时口语对话,并通过多流建模实现对全双工对话动态的建模。Mimi 通过蒸馏法联合建模语义和声学信息,改进了 SpeechTokenizer 的架构和对抗性训练。Moshi 使用了 RQ-Transformer 的变体来增强 Helium,允许对语义和声学标记的层次结构进行建模,而无需增加序列长度。通过对大规模音频进行预训练并创建合成对话,Moshi 展现了优异的表现,并通过内心独白功能实现了流式 TTS 和 ASR 系统。

LLMs Still Can’t Plan; Can LRMs? A Preliminary Evaluation of OpenAI’s o1 on PlanBench:论文详细介绍了传统大语言模型在规划能力上的局限性,并通过 PlanBench 基准测试对其进行了评估。LLM 在 Blocksworld 数据集上的表现虽然有所进步,但在 Mystery Blocksworld 数据集上的表现仍然不佳。随后,文章聚焦于 OpenAI 最近发布的 o1 模型,o1 模型在静态测试数据集上的表现远超 LLM,尤其是在 Blocksworld 测试集上,准确率达到了 97.8%。然而,随着问题规模的增加和复杂性的提升,o1 模型的性能也出现了下降,特别是在处理大型 Blocksworld 问题和无解问题时。论文还指出,尽管 o1 模型在识别无解问题上有所改进,但仍存在挑战,并且其成本效益也不明确。与传统 LLM 相比,o1 模型的运行成本更高,且无法控制推理令牌的生成数量,导致实验成本急剧上升。最后,论文提到了经典规划器 Fast Downward 和 LLM-Modulo 系统,这些系统在成本、速度和准确性上表现出色,且能提供更高的准确性保证。

TC-RAG:Turing-Complete RAG’s Case study on Medical LLM Systems:论文介绍了 TC-RAG(图灵完备的检索增强生成)框架,该框架旨在解决现有 RAG(检索增强生成)方法在处理医疗领域大型语言模型(LLMs)时面临的关键挑战,如幻觉、知识陈旧和专业化查询中的知识限制问题。TC-RAG 通过自适应检索、推理和计划能力强大的内存堆栈系统,以及对系统状态变量的管理,提高了知识检索的效率和准确性。在医疗领域的案例研究中,TC-RAG 在真实世界的医疗数据集上的实验结果表明,其在准确性上至少比现有方法提高了 7.20%。论文还详细介绍了 TC-RAG 的记忆栈定义、操作行为、状态变量的监控与停机问题的解决,以及对比其他方法如 ReACT 的效果评估。

工程

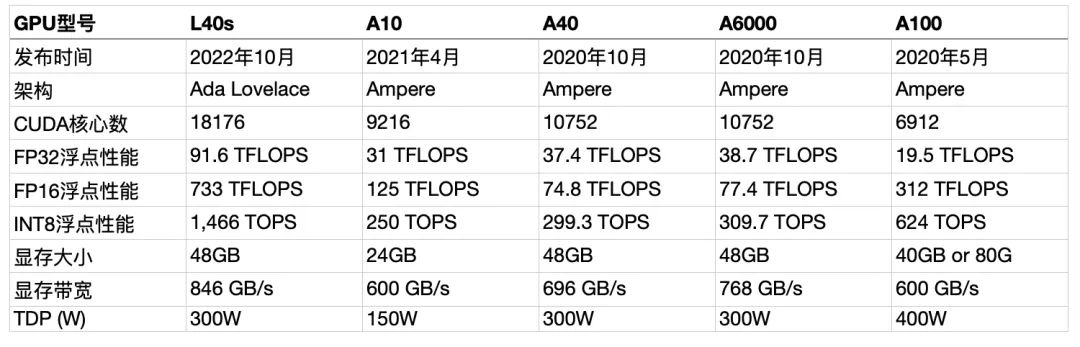

NVIDIA L40s、A10、A40、A100、A6000 哪个GPU 更适合 AI 推理任务?: 本文主要对比了 NVIDIA 的 L40s、A10、A40、A100、A6000 五款 GPU 在 AI 推理任务中的性能和适用性,并提供了选择标准和市场情况。

延伸阅读 对比分析NVIDIA 的 H100、A100、A6000、A4000、V100、P6000、RTX 4000、L40s、L4 九款GPU,哪些更推荐用于模型训练,哪些则更推荐用于推理。

从零开始进行预训练(Pretrain)模型的经验和步骤:文章首先介绍了预训练模型的背景和意义,包括模型的选择、自研的价值以及与开源模型的比较。接着详细讨论了数据环节的重要性,包括数据的爬取、清洗、去重、配比和顺序,以及如何通过数据流水线优化训练过程。在数据清洗方面,强调了使用模型对数据质量进行打分和规则过滤的重要性,并提到了数据脱敏的必要性。在数据去重和配比方面,文章讨论了不同数据源的处理方法和数据的知识密度差异。数据顺序部分提到了课程学习的概念,以及如何通过调整数据顺序来提高模型能力。在模型训练篇,文章讨论了 Tokenizer 的重要性和如何训练 Tokenizer,模型结构的选择,以及如何敲定模型参数和超参数。同时,对比了 Megatron 和 DeepSpeed 两种训练框架的优缺点,并提供了训练技巧和流程的建议。最后,在评估篇,文章探讨了预训练模型的评估方法,包括 PPL(Perplexity)的计算、Benchmark 的使用和改造,以及如何通过概率探针来监控模型的知识能力。文章强调了评估过程中的灵活性和创新性,以及如何通过评估来确保模型效果的持续提升。

OpenAI o1原理逆向工程图解:张俊林在这篇文章中详细分析了 OpenAI o1 模型的重要意义、完整训练过程、可能的模型构成、训练数据类型、RL 在 o1 中的关键要素及 LLM 与 RL 的融合方式,以及 MCST 树搜索在 o1 模型中的应用。

Why Large Language Models Cannot (Still) Actually Reason:大语言模型在处理复杂问题,尤其是需要多步推理的情况时,常常出现错误,虽然它们的回答初步看似逻辑合理,但往往缺乏必要的深入和准确性,在涉及复杂逻辑推理的任务中,模型更容易得出错误结论。OpenAI的o1等模型展现的推理能力看似令人印象深刻,但这并非大语言模型推理能力的全新突破。这实际上是通过在微调阶段引入思维链提示,并利用强化学习使模型选择最合理的推理路径。文章揭示了大语言模型在推理能力上的本质限制,指出了其高级输出与推理能力不匹配的问题。通过分析模型的随机性、计算限制以及缺乏完整计算能力,我们可以理解它们在复杂推理任务中失败的根本原因。此外,本文探讨了当前提升语言模型推理能力的方法,如思维链(CoT)提示和自我批判机制,并对这些方法的有效性和挑战进行了批判性评估。本文的目的是加深人们对大语言模型的能力和局限的理解,并提醒在解读这些看似智能的回答时应保持警惕。

AI Character 角色扮演应用的聊天对话管理方案:角色扮演对话应用具有实时性、快速响应和高频互动等特点,因此会话管理至关重要。为用户提供更自然、流畅的体验,并提高 AI 角色在上下文记录、短期记忆和长期记忆等方面的对话管理能力。文章进一步探讨了会话场景的挑战,包括海量对话数据处理、快速查询与上下文管理、并发访问与数据一致性、长期存储与固定对话轮次以及数据分析等。为了解决这些挑战,文章介绍了三种基于亚马逊云科技数据库的会话管理方案:利用 Amazon DocumentDB、Amazon DynamoDB 和 Aurora Serverless V2 进行会话管理。每种方案都有其特点和优势,例如 DocumentDB 支持 JSON 文件处理和数据压缩功能,DynamoDB 提供强大的可扩展性和无服务器架构,Aurora Serverless V2 则提供了关系数据库的自动扩展能力。文章详细介绍了如何使用这些数据库来存储和处理对话消息,包括表设计、插入和查询会话消息、以及会话信息的过期自动删除等。

训练/微调工具大比拼:本文详细对比了五种不同的深度学习训练 / 微调工具,分别是 Megatron-DeepSpeed、Axolotl、DeepSpeed、Accelerate 和 Unsloth,强调了它们各自的特点、使用场景、优缺点以及区别,并提供了对应的底层实现和推理能力。

产品

OpenAI 推出了高级语音模式:OpenAI 在 2024 年 9 月 24 日宣布,将为 ChatGPT 的付费用户扩展 Advanced Voice Mode(AVM)功能。AVM 旨在使与 ChatGPT 对话更加自然,最初将为 ChatGPT Plus 和 Teams 层级的客户提供。企业和教育版用户将在下周开始获得访问权限。AVM 的设计得到了更新,现在以一个蓝色的动画球体代替了之前的黑色动点。用户将在 ChatGPT 应用中收到一个弹出窗口,提示他们可以使用 AVM。此外,AVM 增加了五种新的声音:Arbor、Maple、Sol、Spruce 和 Vale,共有九种声音可供选择。OpenAI 还改进了 AVM 的声音识别能力,使其更好地理解口音,并使对话更加流畅和迅速。然而,AVM 目前在欧盟、英国、瑞士、冰岛、挪威和列支敦士登等地区尚未可用。此外,OpenAI 还展示了 ChatGPT 的多模态 AI 功能,如视频和屏幕共享,但尚未提供这些功能的上市时间表。

豆包大模型发布视频生成模型:在 2024 年 9 月 24 日举办的 AI 创新巡展上,火山引擎发布了豆包大模型的视频生成模型,该模型具备精准的语义理解和高保真的画质,能够生成多动作多主体交互的视频,支持多种风格和比例,广泛应用于电商营销、动画教育、城市文旅等多个领域。

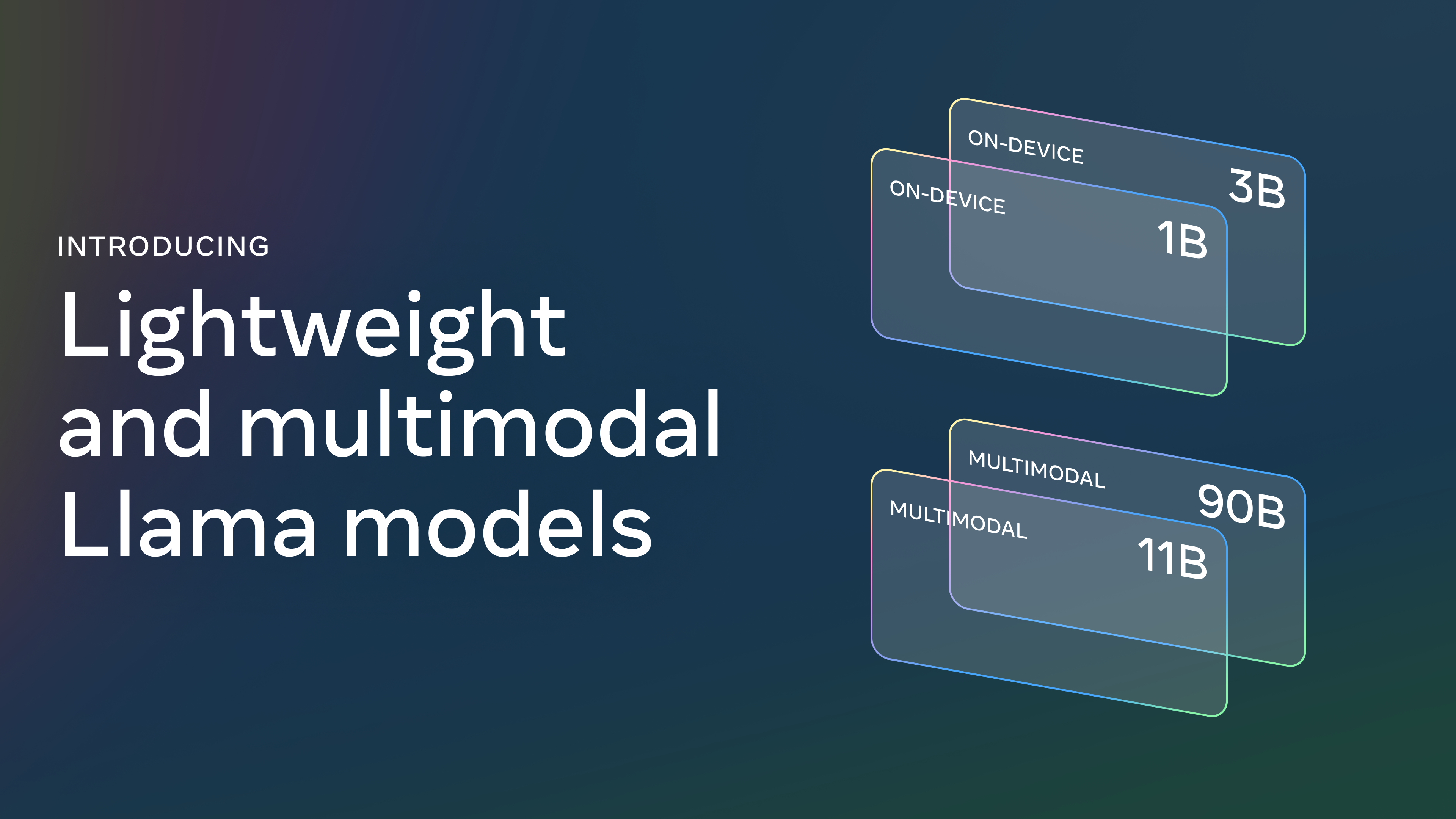

Meta 发布 Llama 3.2 多模态AI模型:Meta 公司宣布发布了 Llama 3.2,这一版本包括 11B 和 90B 的视觉 LLMs,以及 1B 和 3B 的轻量级文本模型,这些模型能够适应边缘和移动设备。Llama 3.2 的 1B 和 3B 模型支持 128K 令牌的上下文长度,并在本地设备上运行,以实现摘要、指令执行和重写任务,同时保持数据不离开设备的隐私。这些模型支持 Qualcomm 和 MediaTek 硬件,并针对 Arm 处理器进行了优化。Llama 3.2 的视觉模型在图像理解任务上超过了闭源模型,如 Claude 3 Haiku,并且提供了预训练和对齐模型,供开发者进行微调以适应特定应用。Meta 还发布了第一批官方的 Llama Stack 分发版本,这些分发版本旨在简化开发者在不同环境中使用 Llama 模型的过程,包括单节点、本地、云和移动设备,Meta 与多家合作伙伴合作,包括 AMD、AWS、Databricks、Dell、Google Cloud、Groq、IBM、Intel、Microsoft Azure、NVIDIA、Oracle Cloud 和 Snowflake 等,以支持 Llama 3.2 模型的服务。

Llama 3.2 的视觉模型支持图像理解和视觉推理,如文档和图表的理解、图像标注和基于自然语言描述的视觉地面化任务。轻量级模型支持多语言文本生成和工具调用,能够在不同的设备上运行,包括 iOS 和 Android 设备。Llama 3.2 模型的评估表明,它们在图像识别和视觉理解任务上与 Claude 3 Haiku 和 GPT4o-mini 等主要基础模型竞争力。

为了使这些模型适应边缘设备,Meta 采用了剪枝和知识蒸馏技术,以减少模型大小,同时保持性能。此外,元 Meta 还提供了 Llama Guard 3 11B Vision 和 Llama Guard 3 1B,这些工具旨在支持图像理解能力,并过滤文本和图像输入提示或输出响应,以确保系统级别的安全性。

市场

垂直 SaaS 如何通过结合 AI 来提高收入:文章预测了 AI 将为垂直 SaaS 开启新时代,在市场营销、销售、客户服务和财务等领域,AI 将取代或增强许多由人执行的机械任务,使得垂直 SaaS 企业能够提供更多的软件功能,不仅增加了每客户的收入,还将开拓那些以往被认为太小或客户获取成本太高的市场。

企业AI应用需求发展趋势:文章首先指出,企业 AI 应用需求可以分为三类:用新技术解决老问题、尝试新方案新产品、科技创新需求。其中,用新技术解决老问题的需求最为旺盛,主要应用于降本增效、提升客服服务水平和销售 / 运维的辅助工具。新产品尝试的需求在今年上半年较多,但后来逐渐减少,提示企业在尝试新方案时需要注意方法,如与技术团队交流和进行 POC 验证。科技创新类需求往往来自于央国企,但价值不明确,除非有实际效率提升的需求。从今年 7 月开始,AI 应用市场出现了明显变化,通用场景的需求趋向于简洁且要求高,如 95% 以上的准确率。专用需求也在增多,尤其是在能源、医药和矿业等行业。文章强调,专注于简约而不简单的任务能够提升解决大而难问题的能力。

State of the Cloud 2024:本篇文章来自 BVP 的 2024 云计算研究报告,主要深入探讨了塑造 AI 云计算经济未来的五大强劲趋势,并对到 2030 年 AI 云计算的发展进行预测。

报告提出了五大趋势,首先是大型科技公司之间围绕 AI 基础模型的激烈竞争。这些模型成为了创新的核心,吸引了大量的风险投资,其中 OpenAI、Anthropic 和 Mistral 等公司在 2023 年获得了 230 亿美元的融资。AI 基础模型的快速进步,包括多模态功能的提升,使得 AI 云的未来充满了不确定性,但也预示着巨大的商业机会。

第二个趋势是 AI 使得所有开发者都能成为 10 倍的生产力。AI 辅助工具,如代码协作者,正在改变开发者的工作方式,使他们能够更快地学习新技术并提高开发效率。预计到 2030 年,开发者的角色将因 AI 而彻底改变,开发能力将成为大多数人的普遍技能。

第三个趋势是多模态模型和 AI 代理的兴起。这些新型模型和代理能够处理文本、图像和语音等多种模式,从而扩展了 AI 的应用范围。报告预测,语音 AI 应用将在未来五年内为软件产业创造 100 亿美元的新市场。

第四个趋势是垂直 AI 的崛起。垂直 AI 应用程序正在取代传统的垂直 SaaS,特别是在服务行业中,它们能够自动化重复性的语言任务。报告预测,垂直 AI 的市值将是传统垂直 SaaS 的 10 倍。

最后一个趋势是消费者云的复兴。AI 技术的进步使得消费者云产品能够提供新的用户体验,从而吸引了大量的用户注意力。报告预测,基于 AI 生成内容的新型消费者云业务将在 2030 年之前成为吸引用户注意力的主要方式。

观点

OpenAI CEO Sam Altman 发布长文《智能时代:The Intelligence Age》,讨论了人工智能如何在未来几十年内带动人类社会进入一个前所未有的繁荣时期。

在未来几十年里,我们将能够做到让祖父母们觉得像是魔法般的事情。

这种现象并非新事物,但它将被加速。人们随着时间的推移变得越来越有能力;我们现在能够完成前人认为不可能的事情。

我们变得更强大,并非因为基因的改变,而是因为我们受益于社会基础设施的智能和能力远超我们个人;在重要意义上,社会本身就是一种高级智能的形式。我们的祖父母,以及他们之前的世代,建造并实现了伟大的成就。他们为全人类都能受益的人类进步的框架做出了贡献。AI 将为人们提供解决难题的工具,并帮助我们添加自己无法独立发现的新支柱到这个框架中。进步的故事将继续,我们的孩子将能够做我们无法做的事情。

这不会一蹴而就,但我们很快就能与能够帮助我们完成比没有 AI 时所能完成的更多任务的 AI 一起工作;最终,每个人都可以拥有一个个人的 AI 团队,里面充满不同领域的虚拟专家,共同努力创造出几乎任何我们能想象的东西。我们的孩子将有虚拟导师,可以提供任何科目、任何语言的个性化指导,并以他们需要的速度进行。我们可以想象类似的思路来改善医疗保健,有能力创造出任何人能想象的任何类型的软件,以及更多。

借助这些新能力,我们可以实现一种看似难以想象的共同繁荣;在未来,每个人的生活都可能比现在任何人生活得更好。仅仅富裕并不一定让人幸福——有很多不幸的富人——但这将显著改善全世界人民的生活。

以下是从一个狭窄的角度看待人类历史的一种方式:经过数千年的科学发现和技术进步的积累,我们学会了如何熔化沙子,添加一些杂质,在极其微小的尺度上以惊人的精确度排列它们,制成计算机芯片,让能量通过这些芯片,最终得到能够生成越来越强大的人工智能系统的系统。

这可能是迄今为止历史上最重要的事实。我们可能在几千天后(!)就会拥有超级智能;这可能需要更长的时间,但我确信我们最终会实现这一目标。

我们是如何走到下一次繁荣飞跃的门槛的?

在三个词中:”深度学习奏效了。”

在 15 个字中:深度学习有效,随着规模扩大可预见到性能提升,我们投入了越来越多的资源。

这就是全部;人类发现了一个算法,这个算法真的能够学习任何数据分布(或者说,真正能够学习产生任何数据分布的“规则”)。在惊人的精确度下,可用的计算资源和数据越多,它就越能帮助人们解决复杂问题。我发现,无论我花多少时间思考这个问题,我永远无法真正理解它的深远影响。

还有很多细节需要我们弄清楚,但被任何特定的挑战分散注意力是个错误。深度学习有效,我们将会解决剩下的问题。我们可以谈论很多事情关于接下来可能发生的事情,但主要的一点是 AI 会随着规模的扩大而变得更好,这将导致全球人民生活有意义的改善。

AI 模型很快将作为自主个人助手为我们服务,代表我们执行特定任务,比如替您协调医疗服务。在未来某个时间点,AI 系统将变得如此出色,帮助我们构建下一代更优秀的系统,并在各个领域推动科学进步。

技术将我们从石器时代带到了农业时代,然后是工业时代。从这里开始,通往智能时代的道路铺满了计算、能源和人类意志。

如果我们想让尽可能多的人拥有 AI,我们需要降低计算成本并使其丰富(这需要大量的能源和芯片)。如果我们不建立足够的基础设施,AI 将成为一种非常有限的资源,战争会围绕它展开,这主要成为富人的工具。

我们需要明智而坚定地行动。智能时代黎明的到来是一个具有重大发展和非常复杂、极其高风险的挑战的时刻。这将不是一个完全正面的故事,但潜在的好处如此巨大,我们有责任,为自己和未来,找出如何应对我们面前的风险的方法。

我相信未来会如此光明,以至于现在尝试描述它的人无法做到公正;智能时代的一个关键特征将是巨大的繁荣。

虽然这将是一个逐步的过程,但令人惊叹的胜利——修复气候、建立空间殖民地以及发现所有物理学——最终将成为常态。拥有几乎无限的智慧和丰富的能源——能够产生伟大想法,并将它们变为现实的能力——我们可以做很多事情。

正如我们所看到的其他技术一样,也会有负面影响,我们需要从现在开始工作,最大化人工智能的好处,同时最小化其危害。例如,我们预计这项技术在未来几年会在劳动力市场(好与坏)中引起重大变化,但大多数工作将比大多数人认为的更缓慢地发生变化,我没有任何恐惧我们会做不完事情(即使它们看起来不像“真正的工作”)。人们天生就有创造和互相帮助的欲望,人工智能将使我们能够以前所未有的方式放大自己的能力。作为一个社会,我们将再次处于一个不断扩大的世界中,我们又可以专注于玩赢者通吃的游戏。

我们现在所做的许多工作,在几百年前的人看来可能像是微不足道的浪费时间,但没有人会回顾过去,希望成为一名路灯管理员。如果一个路灯管理员能看到今天的世界,他会认为他周围的一切繁荣是无法想象的。如果我们能从今天快进一百年,我们周围的一切繁荣也会感觉同样无法想象。

预训练的 Scaling Law 正在走入死胡同,o1 让更多创业公司重新复活:极客公园创始人张鹏和创新工场联合首席执行官汪华、昆仑万维首席科学家颜水成主要讨论了预训练模型的 Scaling Laws 面临的挑战,以及 o1 如何帮助创业公司利用这些模型进行创新。

Vol.22:垂直 SaaS 如何通过 AI 来提高收入?